Edge for Private Cloud Version 4.16.05

In diesem Dokument wird beschrieben, wie Sie ein Rechenzentrum (auch Region genannt) zu vorhandenen Daten hinzufügen in der Mitte.

Überlegungen vor dem Hinzufügen eines Rechenzentrums

Bevor Sie ein Rechenzentrum hinzufügen, müssen Sie wissen, wie OpenLDAP konfiguriert wird, ZooKeeper-, Cassandra- und Postgres-Server in den Rechenzentren. Außerdem müssen Sie sicherstellen, die erforderlichen Ports zwischen den Knoten in den beiden Rechenzentren offen sind.

- OpenLDAP

Jedes Rechenzentrum hat einen eigenen OpenLDAP-Server mit aktivierter Replikation. Wenn Sie das neue Rechenzentrum installieren, müssen Sie OpenLDAP für die Verwendung der Replikation konfigurieren und Sie müssen den OpenLDAP-Server im vorhandenen Rechenzentrum für die Verwendung der Replikation neu konfigurieren. - ZooKeeper

Für die Eigenschaft ZK_HOSTS für Beide Rechenzentren, geben Sie die IP-Adressen oder DNS-Namen aller ZooKeeper-Knoten aus beiden Daten an. in derselben Reihenfolge zentrieren und alle Knoten mit dem Modifikator „:observer“ markieren. Knoten ohne den Modifikator „:observer“ werden als „Voter“ bezeichnet. Du musst eine ungerade Nummer eingeben. Anzahl der „Wähler“ in Ihrer Konfiguration.

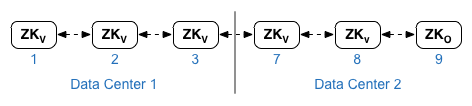

Bei dieser Topologie ist der ZooKeeper-Host auf Host 9 der Beobachter:

In der unten gezeigten Beispielkonfigurationsdatei ist Knoten 9 mit dem ":observer", sodass Sie fünf Wähler erhalten: Knoten 1, 2, 3, 7 und 8.

Für ZK_CLIENT_HOSTS für jedes Rechenzentrum die IP-Adressen oder DNS-Namen des ZooKeeper- Knoten im Rechenzentrum in derselben Reihenfolge für alle ZooKeeper-Knoten in den Daten. in der Mitte. - Cassandra

Alle Rechenzentren müssen die gleiche Anzahl von Cassandra-Knoten haben.

Für CASS_HOSTS pro Daten müssen Sie alle Cassandra-IP-Adressen (nicht DNS-Namen) für beide Daten angeben in unseren Rechenzentren. Listen Sie für Rechenzentrum 1 zuerst die Cassandra-Knoten in diesem Rechenzentrum auf. Für Rechenzentrum 2. Listen Sie zuerst die Cassandra-Knoten in diesem Rechenzentrum auf. Listen Sie die Cassandra-Knoten im selben für alle Cassandra-Knoten im Rechenzentrum.

Alle Cassandra-Knoten müssen das Suffix ':<d>,<r>' haben, z. B. '<ip>:1,1 = Rechenzentrum 1 und Rack/Verfügbarkeitszone 1 und '<ip>:2,1 = Rechenzentrum 2 und Rack/Verfügbarkeitszone 1.

Beispiel: "192.168.124.201:1,1 192.168.124.202:1,1 192.168.124.203:1,1 192.168.124.204:2,1 192.168.124.205:2,1 192.168.124.206:2,1"

Der erste Knoten in der Rack-/Verfügbarkeitszone 1 jedes Rechenzentrums wird als Seed verwendet Server. In diesem Bereitstellungsmodell sieht die Cassandra-Einrichtung so aus:

-

Postgres

Standardmäßig installiert Edge alle Postgres-Knoten im Master-Modus. Wenn Sie jedoch mehrere können Sie Postgres-Knoten für die Verwendung der Master-Stand-by-Replikation konfigurieren. Wenn der ausfallen, kann der Stand-by-Knoten den Traffic weiter verarbeiten. In der Regel konfigurieren Sie den Master-Postgres-Server in einem Rechenzentrum und den Standby-Server im zweiten Rechenzentrum in der Mitte.

Wenn das vorhandene Rechenzentrum bereits so konfiguriert ist, dass zwei Postgres-Knoten ausgeführt werden, heben Sie die Registrierung des vorhandenen Stand-by-Knotens auf und durch einen Standby-Knoten im neuen Rechenzentrum ersetzen.

Die folgende Tabelle zeigt die Konfiguration vor und nach der Postgres-Konfiguration für beide Szenarien:

Vorher

Nachher

Einzelner Master-Postgres-Knoten in dc-1

Master-Postgres-Knoten in dc-1

Stand-by-Postgres-Knoten in dc-2

Master-Postgres-Knoten in dc-1

Stand-by-Postgres-Knoten in dc-1

Master-Postgres-Knoten in dc-1

Stand-by-Postgres-Knoten in dc-2

Registrierung des alten Standby-Postgres-Knotens in dc-1 aufheben

- Portanforderungen

Sie müssen sicherstellen, dass die erforderlichen Ports zwischen den Knoten in den beiden Rechenzentren geöffnet sind. Ein Portdiagramm finden Sie unter Installation Anforderungen.

Bestehendes Rechenzentrum aktualisieren

Wenn Sie ein Rechenzentrum hinzufügen, müssen Sie die Schritte zur Installation und Konfiguration der neuen Daten ausführen Knoten im ursprünglichen Rechenzentrum aktualisieren. Diese sind Änderungen notwendig, da Sie neue Cassandra- und ZooKeeper-Knoten in der neuen die für das bestehende Rechenzentrum zugänglich sein müssen, und Sie müssen OpenLDAP, um Replikation zu verwenden.

Konfigurationsdateien erstellen

Unten sehen Sie die Konfigurationsdateien für die beiden Rechenzentren, in denen jedes hat 6 Knoten. Beachten Sie, dass die Konfigurationsdatei für dc-1 zusätzliche Einstellungen zu Folgendem hinzufügt:

- Konfigurieren Sie OpenLDAP mit Replikation über zwei OpenLDAP-Knoten.

- Fügen Sie der Konfigurationsdatei für dc-1 die neuen Cassandra- und ZooKeeper-Knoten aus dc-2 hinzu.

# Datacenter 1 IP1=IPorDNSnameOfNode1 IP2=IPorDNSnameOfNode2 IP3=IPorDNSnameOfNode3 IP7=IPorDNSnameOfNode7 IP8=IPorDNSnameOfNode8 IP9=IPorDNSnameOfNode9 HOSTIP=$(hostname -i) MSIP=$IP1 ADMIN_EMAIL=opdk@apigee.com APIGEE_ADMINPW=Secret123 LICENSE_FILE=/tmp/license.txt USE_LDAP_REMOTE_HOST=n LDAP_TYPE=2 LDAP_SID=1 LDAP_PEER=$IP7 APIGEE_LDAPPW=secret BIND_ON_ALL_INTERFACES=y MP_POD=gateway-1 REGION=dc-1 ZK_HOSTS="$IP1 $IP2 $IP3 $IP7 $IP8 $IP9:observer" ZK_CLIENT_HOSTS="$IP1 $IP2 $IP3" # Must use IP addresses for CASS_HOSTS, not DNS names. CASS_HOSTS="$IP1:1,1 $IP2:1,1 $IP3:1,1 $IP7:2,1 $IP8:2,1 $IP9:2,1" SKIP_SMTP=n SMTPHOST=smtp.example.com SMTPUSER=smtp@example.com SMTPPASSWORD=smtppwd SMTPSSL=n SMTPPORT=25 |

# Datacenter 2 IP1=IPorDNSnameOfNode1 IP2=IPorDNSnameOfNode2 IP3=IPorDNSnameOfNode3 IP7=IPorDNSnameOfNode7 IP8=IPorDNSnameOfNode8 IP9=IPorDNSnameOfNode9 HOSTIP=$(hostname -i) MSIP=$IP7 ADMIN_EMAIL=opdk@apigee.com APIGEE_ADMINPW=Secret123 LICENSE_FILE=/tmp/license.txt USE_LDAP_REMOTE_HOST=n LDAP_TYPE=2 LDAP_SID=2 LDAP_PEER=$IP1 APIGEE_LDAPPW=secret BIND_ON_ALL_INTERFACES=y MP_POD=gateway-2 REGION=dc-2 ZK_HOSTS="$IP1 $IP2 $IP3 $IP7 $IP8 $IP9:observer" ZK_CLIENT_HOSTS="$IP7 $IP8 $IP9" # Must use IP addresses for CASS_HOSTS, not DNS names. CASS_HOSTS="$IP7:2,1 $IP8:2,1 $IP9:2,1 $IP1:1,1 $IP2:1,1 $IP3:1,1" SKIP_SMTP=n SMTPHOST=smtp.example.com SMTPUSER=smtp@example.com SMTPPASSWORD=smtppwd SMTPSSL=n SMTPPORT=25 |

Vorgehensweise zum Hinzufügen eines neuen Rechenzentrums

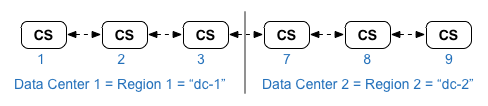

Bei diesem Verfahren werden die Rechenzentren wie folgt benannt:

- dc-1: das vorhandene Rechenzentrum

- dc-2: das neue Rechenzentrum

- Führen Sie auf dc-1 noch einmal "setup.sh" auf den ursprünglichen Cassandra-Knoten mit dem neuen dc-1 aus.

confiig, die die Cassandra-Knoten aus dc-2 enthält:

/opt/apigee/apigee-setup/bin/setup.sh -p ds -f configFile1 - Führen Sie auf dc-1 noch einmal "setup.sh" auf dem Knoten des Verwaltungsservers aus:

> /opt/apigee/apigee-setup/bin/setup.sh -p ms -f configFile1 - Bei dc-2 installieren Sie apigee-setup auf allen Knoten. Weitere Informationen finden Sie unter Edge-Apigee-Setup-Dienstprogramm installieren. Informationen.

- Installieren Sie auf dc-2 Cassandra und ZooKeeper auf den entsprechenden Knoten:

/opt/apigee/apigee-setup/bin/setup.sh -p ds -f configFile2 - Führen Sie auf dc-2 den Befehl "rebuild" auf allen Cassandra-Knoten aus und geben Sie dabei Folgendes an:

Name der Region von dc-1:

> /opt/apigee/apigee-cassandra/bin/nodetool -h cassIP Rebuild dc-1 - Installieren Sie auf dc-2 den Verwaltungsserver auf dem entsprechenden Knoten:

> /opt/apigee/apigee-setup/bin/setup.sh -p ms -f configFile2 - Installieren Sie auf dc-2 die Routen und Nachrichtenprozessoren auf den entsprechenden

Knoten:

> /opt/apigee/apigee-setup/bin/setup.sh -p rmp -f configFile2 - Installieren Sie auf dc-2 Qpid auf den entsprechenden Knoten:

> /opt/apigee/apigee-setup/bin/setup.sh -p qs -f configFile2 - Installieren Sie auf dc-2 Postgres auf dem entsprechenden Knoten:

> /opt/apigee/apigee-setup/bin/setup.sh -p ps -f configFile2 - Richten Sie den Postgres-Master/Standby für die Postgres-Knoten ein. Der Postgres-Knoten in dc-1 ist der

und der Postgres-Knoten in dc-2 ist der Stand-by-Server.

Hinweis: Wenn dc-1 bereits für zwei Postgres konfiguriert ist im Master-/Stand-by-Modus ausgeführt werden, verwenden Sie im Rahmen dieses Verfahrens die Methode vorhandenen Master-Postgres-Knoten in dc-1 als Master und der Postgres-Knoten in dc-2 als Standby-Server. Später in diesem Verfahren hebt die Registrierung des vorhandenen Postgres-Standby-Servers in dc-1 auf.- Bearbeiten Sie auf dem Masterknoten in dc-1 die Konfigurationsdatei, um Folgendes festzulegen:

PG_MASTER=IPorDNSofDC1Master

PG_STANDBY=IPorDNSofDC2Standby - Aktivieren Sie die Replikation auf dem neuen Master:

> /opt/apigee/apigee-service/bin/apigee-service apigee-postgresql Setup-Replikation-auf-Master -f configFIle - Bearbeiten Sie die Konfigurationsdatei auf dem Standby-Knoten in dc-2, um Folgendes festzulegen:

PG_MASTER=IPorDNSofDC1Master

PG_STANDBY=IPorDNSofDC2Standby - Beenden Sie auf dem Standby-Knoten in dc-2 den Server und löschen Sie dann

Vorhandene Postgres-Daten:

> /opt/apigee/apigee-service/bin/apigee-service apigee-postgresql stop

> rm -rf /opt/apigee/data/apigee-postgresql/

Hinweis: Bei Bedarf können Sie diese Daten vor dem Löschen sichern. - Konfigurieren Sie den Stand-by-Knoten in dc-2:

> /opt/apigee/apigee-service/bin/apigee-service apigee-postgresql Setup-replication-on-standby -f configFile

- Bearbeiten Sie auf dem Masterknoten in dc-1 die Konfigurationsdatei, um Folgendes festzulegen:

- Aktualisieren Sie auf dc-1 die Analysekonfiguration und konfigurieren Sie die Organisationen.

- Rufen Sie auf dem Verwaltungsserverknoten von dc-1 die UUID des Postgres ab.

Knoten:

> apigee-adminapi.sh-Server list -r dc-1 -p analytics -t postgres-server --admin adminEmail --pwd adminPword –-host localhost

Die UUID wird am Ende der zurückgegebenen Daten angezeigt. Speichern Sie diesen Wert.

Hinweis: Wenn dc-1 so konfiguriert ist, dass zwei Postgres-Knoten ausgeführt werden, verwenden, werden in der Ausgabe zwei IP-Adressen und UUIDs angezeigt. Speichern Sie beide UUIDs. Anhand der IP-Adressen sollten Sie erkennen können, welche UUID für den Master gilt und welche für zum Standby-Knoten. - Rufen Sie auf dem Verwaltungsserverknoten von dc-2 die UUID des Postgres ab. wie im vorherigen Schritt gezeigt. Speichern Sie diesen Wert.

- Bestimmen Sie auf dem Verwaltungsserverknoten von dc-1 den Namen des

Analysen und Nutzergruppen. Viele der folgenden Befehle erfordern diese Information.

Standardmäßig lautet der Name der Analysegruppe "axgroup-001" und der Name des Nutzers „group“ ist „consumer-group-001“. In der Datei für die stille Konfiguration für eine Region können Sie den Namen der Analysegruppe mithilfe der AXGROUP-Eigenschaft an.

Wenn Sie sich bezüglich der Namen der Analyse- und Nutzergruppen nicht sicher sind, verwenden Sie Folgendes: um sie anzuzeigen:

> Apigee-adminapi.sh Analytics Gruppenliste --admin adminEmail --pwd adminPword --host localhost

Dieser Befehl gibt den Namen der Analysegruppe im Namensfeld und die Nutzergruppe zurück name im Feld „consumer-groups“ (Nutzergruppen) ein. - Entfernen Sie auf dem Verwaltungsserverknoten von dc-1 das vorhandene Postgres.

Server aus der Analysegruppe:

<ph type="x-smartling-placeholder">

- </ph>

- Entfernen Sie den Postgres-Knoten aus der Nutzergruppe:

> apigee-adminapi.sh analytics groups consumer_groups datastores remove -g axgroup-001 -c consumer-group-001 -u UUID -Y --admin adminEmail --pwd adminPword --host localhost

Wenn dc-1 so konfiguriert ist, dass zwei Postgres-Knoten ausgeführt werden, Master-/Standby-Modus, entfernen Sie beide:

> apigee-adminapi.sh analytics groups consumer_groups datastores remove -g axgroup-001 -c consumer-group-001 -u "UUID_1,UUID_2" -Y --admin adminEmail --pwd adminPword –-host localhost - Entfernen Sie den Postgres-Knoten aus der Analysegruppe:

> apigee-adminapi.sh analytics groups postgres_server remove -g axgroup-001 -u UUID -Y --admin adminEmail --pwd adminPword --host localhost

Wenn dc-1 so konfiguriert ist, dass zwei Postgres-Knoten im Master-/Standby-Modus ausgeführt werden, entfernen Sie Beide:

> apigee-adminapi.sh Analytics Groups postgres_server remove -g axgroup-001 -u UUID1,UUID2 -Y --admin adminEmail --pwd adminPword –-host localhost

- Entfernen Sie den Postgres-Knoten aus der Nutzergruppe:

-

Fügen Sie auf dem Verwaltungsserverknoten von dc-1 den neuen Master bzw. die Standby-Instanz hinzu.

Postgres-Server an die Analysegruppe:

<ph type="x-smartling-placeholder">

- </ph>

- Fügen Sie beide Postgres-Server zur Analysegruppe hinzu:

> apigee-adminapi.sh Analytics Groups postgres_server add -g axgroup-001 -u "UUID_1,UUID_2" --admin adminEmail --pwd adminPword --host localhost

wobei UUID_1 dem Postgres-Masterknoten in dc-1 und UUID_2 entspricht dem Standby-Postgres Knoten in dc-2. - PG-Server als Master/Standby zur Nutzergruppe hinzufügen:

> apigee-adminapi.sh Analytics groupsconsumer_groups datastores add -g axgroup-001 -cconsumer-group-001 -u „UUID_1,UUID_2“ --admin adminEmail --pwd adminPword –-host localhost

- Fügen Sie beide Postgres-Server zur Analysegruppe hinzu:

- Fügen Sie der Analysegruppe die Qpid-Server aus dc-2 hinzu:

<ph type="x-smartling-placeholder">

- </ph>

- Rufen Sie auf dem Verwaltungsserverknoten von dc-1 die UUIDs der Qpid ab.

Knoten in dc-2:

> apigee-adminapi.sh server list -r dc-2 -p center -t qpid-server --admin adminEmail --pwd adminPword --host localhost

Die UUIDs werden am Ende der zurückgegebenen Daten angezeigt. Speichern Sie diese Werte. - Fügen Sie auf dem Verwaltungsserver-Knoten von dc-1 die Qpid-Knoten zum

Analysegruppe:

>apigee-adminapi.sh Analysegruppen qpid_server add -g axgroup-001 -u "UUID_1,UUID_2" --admin adminEmail --pwd adminPword --host localhost - Fügen Sie auf dem Verwaltungsserver-Knoten von dc-1 die Qpid-Knoten zum

Verbrauchergruppe:

> apigee-adminapi.sh Analytics Groups Kundengruppen hinzufügen -g axgroup-001 -c Consumer-Gruppe-001 -u "UUID_1,UUID_2" --admin adminEmail --pwd adminPword –-host localhost

- Rufen Sie auf dem Verwaltungsserverknoten von dc-1 die UUIDs der Qpid ab.

Knoten in dc-2:

- Heben Sie die Registrierung des alten Postgres-Standby-Servers von dc-1 auf und löschen Sie ihn:

<ph type="x-smartling-placeholder">

- </ph>

- Heben Sie die Registrierung des vorhandenen Postgres-Standby-Servers dc-1 auf:

> apigee-adminapi.sh Server deregister -u UUID -r dc-1 -p analytics -t postgres-server -Y --admin adminEmail --pwd adminPword --host localhost

wobei UUID der alte Standby-Modus ist Postgres-Knoten in dc-1. - Löschen Sie den vorhandenen dc-1-Postgres-Standby-Server:

Hinweis: Mit diesem Befehl wird der Postgres-Serverknoten nicht deinstalliert. Es wird er nur aus der Liste der Edge-Knoten entfernt. Sie können Postgres später über die -Knotens hinzufügen.

> apigee-adminapi.sh Servers delete -u UUID --admin adminEmail --pwd adminPword –-host localhost

- Heben Sie die Registrierung des vorhandenen Postgres-Standby-Servers dc-1 auf:

- Rufen Sie auf dem Verwaltungsserverknoten von dc-1 die UUID des Postgres ab.

Knoten:

- Führen Sie den folgenden nodetool-Befehl auf allen Cassandra-Knoten in dc-1 aus, um Arbeitsspeicher freizugeben:

> /opt/apigee/apigee-cassandra/bin/nodetool -h cassandraIP Bereinigung - Für jede Organisation und jede Umgebung, die Sie datenübergreifend unterstützen möchten

Zentren:

<ph type="x-smartling-placeholder">

- </ph>

- Fügen Sie auf dem Verwaltungsserverknoten von dc-1 das neue MP_POD zum

Organisation:

> Apigee-adminapi.sh Organisations-Pods add -o orgName -r dc-2 -p gateway-2 --admin adminEmail --pwd adminPword --host localhost

Dabei ist gateway-2 der Name des Gateway-Pods gemäß Definition im MP_POD. in der dc-2-Konfigurationsdatei. - Fügen Sie der Organisation und Umgebung die neuen Message Processors hinzu:

<ph type="x-smartling-placeholder">

- </ph>

- Rufen Sie auf dem Verwaltungsserverknoten von dc-2 die UUIDs der

Message Processor-Knoten in dc-2:

> apigee-adminapi.sh Server list -r dc-2 -p gateway-2 -t message-processor --admin adminEmail --pwd adminPword --host localhost

Die UUIDs werden am Ende der zurückgegebenen Daten angezeigt. Speichern Sie diese Werte. - Auf dem Verwaltungsserverknoten von dc-1 für jeden Message Processor

Fügen Sie in dc-2 den Message Processor einer Umgebung für die Organisation hinzu:

> Apigee-adminapi.sh-Organisationen envs server add -o orgName -e envName -u UUID --admin adminEmail --pwd adminPword –-host localhost

- Rufen Sie auf dem Verwaltungsserverknoten von dc-2 die UUIDs der

Message Processor-Knoten in dc-2:

- Prüfen Sie auf dem Verwaltungsserverknoten von dc-1 die Organisation:

> Apigee-adminapi.sh Organisations-APIs Deployments -o orgName -a apiProxyName --admin adminEmail --pwd adminPword --host localhost

Dabei ist apiProxyName der Name eines API-Proxys, der im Unternehmen.

- Fügen Sie auf dem Verwaltungsserverknoten von dc-1 das neue MP_POD zum

Organisation: