Stai visualizzando la documentazione di Apigee Edge.

Vai alla documentazione di Apigee X. info

Puoi utilizzare Edge Microgateway per fornire la gestione delle API Apigee per i servizi in esecuzione in un cluster Kubernetes. Questo argomento spiega perché potresti voler eseguire il deployment di Edge Microgateway su Kubernetes e descrive come eseguire il deployment di Edge Microgateway su Kubernetes come servizio.

Caso d'uso

I servizi di cui è stato eseguito il deployment in Kubernetes espongono comunemente API a consumatori esterni o ad altri servizi in esecuzione all'interno del cluster.

In entrambi i casi, c'è un problema importante da risolvere: come gestirai queste API? Ad esempio:

- Come li proteggerai?

- Come gestirai il traffico?

- Come farai a ottenere informazioni su pattern di traffico, latenze ed errori?

- Come pubblicherai le tue API in modo che gli sviluppatori possano trovarle e utilizzarle?

Che tu stia eseguendo la migrazione di API e servizi esistenti allo stack Kubernetes o che stia creando nuovi servizi e API, Edge Microgateway ti aiuta a fornire un'esperienza di gestione delle API chiara che include sicurezza, gestione del traffico, analisi, pubblicazione e altro ancora.

Eseguire Edge Microgateway come servizio

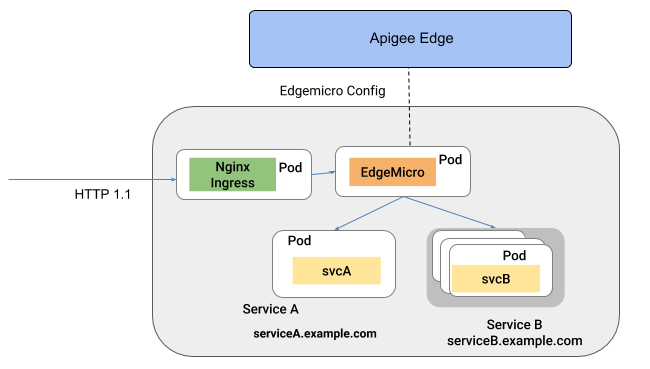

Quando viene eseguito il deployment in Kubernetes come servizio, Edge Microgateway viene eseguito nel proprio pod. In questa architettura, Edge Microgateway intercetta le chiamate API in arrivo e le inoltra a uno o più servizi target in esecuzione in altri pod. In questa configurazione, Edge Microgateway fornisce funzionalità di gestione delle API come sicurezza, analisi, gestione del traffico e applicazione dei criteri agli altri servizi.

La figura seguente illustra l'architettura in cui Edge Microgateway viene eseguito come servizio in un cluster Kubernetes:

Consulta Eseguire il deployment di Edge Microgateway come servizio in Kubernetes.

Passaggio successivo

- Per scoprire come eseguire Edge Microgateway come servizio in Kubernetes, consulta Eseguire il deployment di Edge Microgateway come servizio in Kubernetes.