Sie sehen sich die Dokumentation zu Apigee Edge an.

Sehen Sie sich die Apigee X-Dokumentation an. info

Berechtigungen für zugewiesene Dienst-Agents einrichten

Führen Sie die folgenden Schritte aus, um Berechtigungen für zugewiesene Kundenservicemitarbeiter einzurichten und sich auf die oben beschriebenen Änderungen vorzubereiten.

- Geben Sie den folgenden Befehl ein, um den Namen Ihres Google Cloud-Kundenservicemitarbeiters zu ermitteln:

curl -X GET \ "https://api.enterprise.apigee.com/v1/organizations/ORG" \ -u email:password \ | jq -r '.properties.property[] | select(.name=="serviceAgent.analytics") | .value'

ORG ist Ihre Organisation. Dadurch werden der Name und der Wert des Kundenservicemitarbeiters zurückgegeben, wie unten dargestellt:

"property" : [ { "name" : "serviceAgent.analytics", "value" : "service-9q1ibk@gcp-sa-apigee-uap.iam.gserviceaccount.com" }, - Öffnen Sie in der Google Cloud Console das IAM-Dashboard.

- Wählen Sie Ihr Google Cloud-Projekt aus.

- Klicken Sie oben im Bereich IAM auf Hinzufügen.

- Geben Sie im Feld Neue Hauptkonten den Dienst-Agenten

valueein, der in Schritt 1 zurückgegeben wurde. Dievaluein Schritt 1 ist beispielsweiseservice-9q1ibk@gcp-sa-apigee-uap.iam.gserviceaccount.com. - Klicken Sie auf die Schaltfläche + Weitere Rolle hinzufügen und fügen Sie die folgenden Rollen hinzu:

- BigQuery-Nutzer

- Storage-Administrator

- Klicken Sie auf Speichern.

Apigee Analytics-Daten

Apigee Analytics erfasst und analysiert ein breites Spektrum an Daten, die durch Ihre APIs fließen, und bietet Visualisierungstools, einschließlich interaktiver Dashboards, benutzerdefinierter Berichte und anderer Tools, die Trends in der API-Proxy-Leistung erkennen. Jetzt können Sie auf diese umfangreichen Inhalte zugreifen, indem Sie Analysedaten aus Apigee Analytics in Ihr eigenes Daten-Repository exportieren, z. B. in Google Cloud Storage oder Google BigQuery. Anschließend können Sie die leistungsstarken Funktionen für Abfragen und maschinelles Lernen von Google BigQuery und TensorFlow nutzen, um Ihre eigenen Datenanalysen durchzuführen. Sie können die exportierten Analysedaten auch mit anderen Daten wie Weblogs kombinieren, um neue Einblicke in Ihre Nutzer, APIs und Anwendungen zu erhalten.Exportdatenformat

Exportieren Sie Analysedaten in eines der folgenden Formate:

Kommagetrennte Werte (CSV)

Das Standardtrennzeichen ist ein Komma (,). Zu den unterstützten Trennzeichen gehören das Komma (), der senkrechte Strich (|) und das Tabulatorzeichen (\t). Konfigurieren Sie den Wert mit dem Attribut

csvDelimiter. Eine Beschreibung hierzu finden Sie unter Referenz zu Anfragattribut exportieren.JSON (durch Zeilenumbruch getrennt)

Ermöglicht das Verwenden eines Zeilenvoschubs als Trennzeichen.

Die exportierten Daten enthalten alle in Edge integrierten Analysemesswerte und -dimensionen sowie alle benutzerdefinierten Analysedaten, die Sie hinzufügen. Eine Beschreibung der exportierten Daten finden Sie in der Referenz zu Analysemesswerten, -dimensionen und -filtern.

Sie können Analysedaten in die folgenden Daten-Repositories exportieren:

Exportvorgang

In den folgenden Schritten wird der Prozess für das Exportieren der Analysedaten zusammengefasst:

Konfigurieren Sie Ihr Daten-Repository (Cloud Storage oder BigQuery) für den Datenexport. Sie müssen sicherstellen, dass Ihr Daten-Repository korrekt konfiguriert wurde und dass das Dienstkonto, mit dem Daten in das Daten-Repository geschrieben werden, die richtigen Berechtigungen hat.

Erstellen Sie einen Datenspeicher, der die Eigenschaften des Daten-Repositorys (Cloud Storage oder BigQuery) definiert, in das Sie Ihre Daten exportieren, einschließlich der Anmeldeinformationen, die für den Zugriff auf das Daten-Repository verwendet werden.

Wenn Sie einen Datenspeicher erstellen, laden Sie die Anmeldeinformationen für das Daten-Repository in den Edge-Anmeldeinformations-Vault hoch, um sie sicher zu speichern. Der Datenexportmechanismus verwendet dann diese Anmeldedaten, um Daten in Ihr Datenrepository zu schreiben.

Verwenden Sie die Datenexport-API, um den Datenexport zu initiieren. Der Datenexport wird asynchron im Hintergrund ausgeführt.

Verwenden Sie die Datenexport-API, um festzustellen, wann der Export abgeschlossen ist.

Wenn der Export abgeschlossen ist, greifen Sie in Ihrem Daten-Repository auf die exportierten Daten zu.

Diese Schritte werden in den folgenden Abschnitten näher erläutert.

Daten-Repository konfigurieren

Der Mechanismus zum Exportieren von Analysedaten schreibt Daten in Cloud Storage oder BigQuery. Damit diese Schreibvorgänge erfolgen können, müssen folgende Voraussetzungen erfüllt sein:

- Erstellen Sie ein Google Cloud-Dienstkonto.

- Legen Sie die Rolle des Dienstkontos so fest, dass es auf Cloud Storage oder BigQuery zugreifen kann.

Dienstkonto für Cloud Storage oder BigQuery erstellen

Ein Dienstkonto ist ein Google-Konto, das zu Ihrer Anwendung und nicht zu einem einzelnen Nutzer gehört. Ihre Anwendung verwendet dann das Dienstkonto, um auf einen Dienst zuzugreifen.

Ein Dienstkonto hat einen Dienstkontoschlüssel, der durch einen JSON-String dargestellt wird. Wenn Sie den Edge-Datenspeicher erstellen, der die Verbindung zu Ihrem Datenrepository definiert, geben Sie diesen Schlüssel an. Der Datenexportmechanismus verwendet dann den Schlüssel, um auf Ihr Datenrepository zuzugreifen.

Das mit dem Schlüssel verknüpfte Dienstkonto muss Inhaber eines Google Cloud-Projekts sein und Schreibzugriff auf den Google Cloud Storage-Bucket haben. Informationen zum Erstellen eines Dienstschlüssels und zum Herunterladen der erforderlichen Nutzdaten finden Sie unter Dienstkontoschlüssel erstellen in der Google Cloud Platform-Dokumentation.

Wenn Sie Ihren Schlüssel zum ersten Mal herunterladen, wird er beispielsweise als JSON-Objekt formatiert:

{ "type": "service_account", "project_id": "myProject", "private_key_id": "12312312", "private_key": "-----BEGIN PRIVATE KEY-----\n...", "client_email": "client_email@developer.gserviceaccount.com", "client_id": "879876769876", "auth_uri": "https://accounts.google.com/organizations/oauth2/auth", "token_uri": "https://oauth2.googleapis.com/token", "auth_provider_x509_cert_url": "https://www.googleapis.com/oauth2", "client_x509_cert_url": "https://www.googleapis.com" }

Google Cloud Storage konfigurieren

Bevor Sie Daten nach Google Cloud Storage exportieren können:

- Die BigQuery- und Cloud Resource Manager-APIs müssen in Ihrem Google Cloud Platform-Projekt aktiviert sein. Eine Anleitung finden Sie unter APIs aktivieren. Apigee nutzt die BigQuery API, um BigQuery-Exportfeatures beim Export nach Cloud Storage zu nutzen, und die Cloud Resource Manager API, um vor jedem Export die Berechtigung zu prüfen.

Achten Sie darauf, dass dem Dienstkonto die folgenden Rollen zugewiesen sind:

- BigQuery Job User

- Storage-Objekt-Ersteller

- Storage Admin (nur erforderlich, um den Datenspeicher zu testen, wie in Testen einer Datenspeicher-Konfiguration beschrieben). Wenn diese Rolle zu breit ist, können Sie stattdessen die Berechtigung

storage.buckets.getzu einer vorhandenen Rolle hinzufügen.)

Wenn Sie eine vorhandene Rolle ändern oder eine benutzerdefinierte Rolle erstellen möchten, fügen Sie der Rolle die folgenden Berechtigungen hinzu:

bigquery.jobs.createstorage.objects.createstorage.buckets.get(nur für das Testen des Datenspeichers erforderlich, wie unter Testen einer Datenspeicher-Konfiguration beschrieben)

Google BigQuery konfigurieren

Bevor Sie Daten nach Google BigQuery exportieren können:

- Die BigQuery- und Cloud Resource Manager-APIs müssen in Ihrem Google Cloud Platform-Projekt aktiviert sein. Eine Anleitung finden Sie unter APIs aktivieren. Apigee verwendet die Cloud Resource Manager API, um vor jedem Export die Berechtigung zu prüfen.

- Die BigQuery API muss in Ihrem Google Cloud Platform-Projekt aktiviert sein. Eine Anleitung finden Sie unter APIs aktivieren und deaktivieren.

Achten Sie darauf, dass dem Dienstkonto die folgenden Rollen zugewiesen sind:

- BigQuery Job User

- BigQuery-Dateneditor

Wenn Sie eine vorhandene Rolle ändern oder eine benutzerdefinierte Rolle erstellen möchten, fügen Sie der Rolle die folgenden Berechtigungen hinzu:

bigquery.datasets.createbigquery.datasets.getbigquery.jobs.createbigquery.tables.createbigquery.tables.getbigquery.tables.updateData

Datenspeicher erstellen

Der Datenspeicher definiert die Verbindung zu Ihrem Exportdaten-Repository (Cloud Storage, BigQuery), einschließlich der Anmeldeinformationen für den Zugriff auf das Daten-Repository.

Informationen zum Edge-Vault für Anmeldedaten

Edge verwendet den Anmeldeinformations-Vault, um die Anmeldeinformationen für den Zugriff auf Ihr Exportdaten-Repository sicher zu speichern. Damit ein Dienst auf die Anmeldeinformationen im Edge Vault für Anmeldeinformationen zugreifen kann, müssen Sie einen Konsument für Anmeldeinformationen definieren.

Wenn Sie einen Datenspeicher mithilfe der Edge-Benutzeroberfläche erstellen, wie unten beschrieben, erstellt Edge automatisch den Consumer, der für den Zugriff auf die Anmeldeinformationen verwendet wird.

Datenspeicherkonfiguration testen

Wenn Sie den Datenspeicher erstellen, testet oder überprüft Edge nicht, ob Ihre Anmeldeinformationen und die Daten-Repository-Konfiguration gültig sind. Das bedeutet, dass Sie den Datenspeicher erstellen können und bis zum ersten Datenexport keine Fehler erkennen können.

Alternativ können Sie die Konfiguration des Datenspeichers vor dem Erstellen testen. Das Testen ist hilfreich, da die Ausführung eines umfangreichen Datenexportvorgangs sehr lange dauern kann. Wenn Sie Ihre Anmeldedaten und die Konfiguration des Datenspeichers testen, bevor Sie mit dem Herunterladen großer Datenmengen beginnen, können Sie Probleme mit Ihren Einstellungen schnell beheben.

Wenn der Test erfolgreich ist, erstellen Sie den Datenspeicher. Wenn der Test fehlschlägt, beheben Sie die Fehler und testen Sie die Konfiguration noch einmal. Sie erstellen den Datenspeicher erst, nachdem die Tests erfolgreich waren.

Um die Testfunktion zu aktivieren, müssen Sie Folgendes tun:

- Achten Sie darauf, dass die Cloud Resource Manager API in Ihrem Google Cloud-Projekt aktiviert ist. Eine Anleitung finden Sie unter APIs aktivieren und deaktivieren.

Datenspeicher erstellen

So erstellen Sie einen Datenspeicher in der Benutzeroberfläche:

Melden Sie sich als Organisationsadministrator unter https://apigee.com/edge an und wählen Sie Ihre Organisation aus.

HINWEIS: Sie müssen ein Edge-Organisationsadministrator sein, um einen Datenspeicher erstellen zu können.

Wählen Sie in der linken Navigationsleiste Verwaltung > Analytics-Datenspeicher aus. Die Seite Analytics Datastores wird angezeigt.

Wählen Sie die Schaltfläche + Datastore hinzufügen aus. Sie werden aufgefordert, den Datenspeichertyp auszuwählen:

Wählen Sie einen Zieltyp für Exportdaten aus:

- Google Cloud Storage

- Google BigQuery

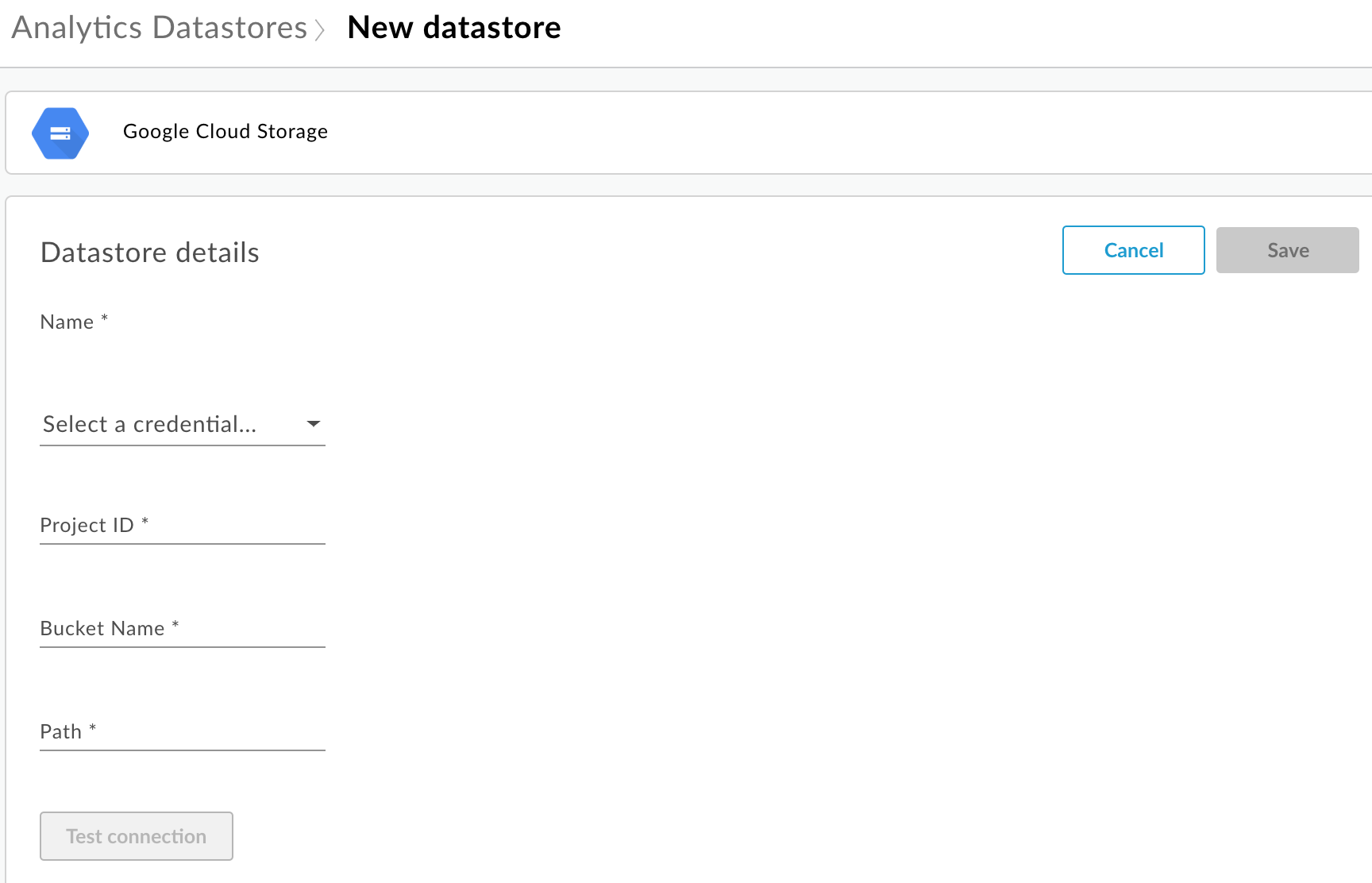

Die Konfigurationsseite wird angezeigt:

Geben Sie den Namen des Datenspeichers ein.

Wählen Sie einen Berechtigungsnachweis für den Zugriff auf das Datenrepository aus. Eine Drop-down-Liste mit verfügbaren Anmeldedaten wird angezeigt.

Die Anmeldedaten sind spezifisch für einen Daten-Repository-Typ. Weitere Informationen finden Sie unter Dienstkonto für Cloud Storage oder BigQuery erstellen.

Wenn Sie die Anmeldedaten bereits hochgeladen haben, wählen Sie sie aus der Drop-down-Liste aus. Achten Sie darauf, dass Sie Anmeldedaten für den Datenspeichertyp auswählen.

Wenn Sie dem Datenspeicher neue Anmeldeinformationen hinzufügen, wählen Sie Neu hinzufügen aus. Geben Sie im Dialogfeld Folgendes ein:

- Name der Anmeldedaten

- Der Inhalt der Anmeldeinformationen ist der JSON-Dienstkontoschlüssel, der für Ihr Datenrepository spezifisch ist, wie unter Erstellen eines Dienstkontos für Cloud Storage oder BigQuery definiert.

- Wählen Sie Erstellen aus.

Geben Sie die für den Daten-Repository-Typ spezifischen Eigenschaften ein:

- Für Google Cloud Storage:

Attribut Beschreibung Erforderlich? Projekt-ID Google Cloud Platform-Projekt-ID Informationen zum Erstellen eines Google Cloud Platform-Projekts finden Sie unter Projekte erstellen und verwalten in der Google Cloud Platform-Dokumentation.

Ja Bucket-Name Name des Buckets in Cloud Storage, in den Sie Analysedaten exportieren möchten. Der Bucket muss vorhanden sein, bevor Sie einen Datenexport durchführen. Informationen zum Erstellen eines Cloud Storage-Buckets finden Sie unter Storage-Buckets erstellen in der Google Cloud Platform-Dokumentation.

Ja Pfad Verzeichnis, in dem die Analysedaten im Cloud Storage-Bucket gespeichert werden sollen. Ja - Für BigQuery:

Attribut Beschreibung Erforderlich? Projekt-ID Google Cloud Platform-Projekt-ID Informationen zum Erstellen eines Google Cloud Platform-Projekts finden Sie unter Projekte erstellen und verwalten in der Google Cloud Platform-Dokumentation.

Ja Dataset-Name Name des BigQuery-Datasets, in das Sie Analysedaten exportieren möchten. Das Dataset muss erstellt werden, bevor Sie den Datenexport anfordern. Informationen zum Erstellen eines BigQuery-Datasets finden Sie unter Datasets erstellen und verwenden in der Dokumentation zur Google Cloud Platform.

Ja Tabellenpräfix Das Präfix für die Namen der Tabellen, die für die Analysedaten im BigQuery-Dataset erstellt wurden. Ja

- Für Google Cloud Storage:

Wählen Sie Verbindung testen aus, um sicherzustellen, dass die Anmeldeinformationen für den Zugriff auf das Datenrepository verwendet werden können.

Wenn der Test erfolgreich ist, speichern Sie Ihren Datenspeicher.

Wenn der Test fehlschlägt, beheben Sie alle Probleme und wiederholen Sie den Test. Bewegen Sie den Mauszeiger auf die Fehlermeldung in der Benutzeroberfläche, um weitere Informationen in einem Tooltip anzuzeigen.

Nachdem der Verbindungstest bestanden wurde, speichern Sie den Datenspeicher.

Datenspeicher ändern

So ändern Sie einen Datenspeicher:

Melden Sie sich als Organisationsadministrator unter https://apigee.com/edge an und wählen Sie Ihre Organisation aus.

Wählen Sie in der linken Navigationsleiste Verwaltung > Analytics-Datenspeicher aus. Die Seite Analytics Datastores wird angezeigt.

Bewegen Sie den Mauszeiger auf die Spalte Geändert des zu ändernden Berichts. Das Symbol „Bearbeiten“ und „Löschen“ wird angezeigt.

Bearbeiten oder löschen Sie den Datenspeicher.

Wenn Sie den Datenspeicher bearbeitet haben, wählen Sie Verbindung testen aus, um sicherzustellen, dass die Anmeldeinformationen für den Zugriff auf den Datenspeicher verwendet werden können.

Wenn der Test erfolgreich ist, können Sie die Beispieldaten in Ihrem Datenrepository anzeigen.

Wenn der Test fehlschlägt, beheben Sie alle Probleme und wiederholen Sie den Test.

Nachdem der Verbindungstest bestanden wurde, aktualisieren Sie den Datenspeicher.

Analysedaten exportieren

Senden Sie eine POST-Anfrage an die /analytics/exports API, um Analysedaten zu exportieren. Übergeben Sie im Anfragetext die folgenden Informationen:

- Name und Beschreibung der Exportanfrage

- Zeitraum der exportierten Daten (Wert kann nur einen Tag umfassen)

- Format der exportierten Daten

- Name des Datenspeichers

- Gibt an, ob die Monetarisierung für die Organisation aktiviert ist

Beispiele für Exportanfragen finden Sie unten. Eine vollständige Beschreibung der Anfragetext-Attribute finden Sie unter Referenz zu Anfrageattribut exportieren.

Die Antwort vom POST hat folgendes Format:

{

"self": "/organizations/myorg/environments/test/analytics/exports/a7c2f0dd-1b53-4917-9c42-a211b60ce35b",

"created": "2017-09-28T12:39:35Z",

"state": "enqueued"

}

Beachten Sie, dass das Attribut state in der Antwort auf enqueued gesetzt ist. Die POST-Anfrage funktioniert asynchron. Dies bedeutet, dass sie im Hintergrund ausgeführt wird, nachdem die Anfrage eine Antwort zurückgegeben hat. Zulässige Werte für state sind: enqueued, running, completed, failed.

Verwenden Sie die im Attribut self zurückgegebene URL, um den Status der Datenexportanfrage anzuzeigen, wie unter Status einer Analyseexportanfrage ansehen beschrieben. Wenn die Anfrage abgeschlossen ist, wird der Wert des Attributs state in der Antwort auf completed gesetzt. Sie können dann auf die Analysedaten in Ihrem Daten-Repository zugreifen.

Beispiel 1: Daten in Cloud Storage exportieren

Die folgende Anforderung exportiert einen vollständigen Satz Rohdaten für die letzten 24 Stunden aus der Testumgebung in der myorg-Organisation. Der Inhalt wird im JSON-Format nach Cloud Storage exportiert:

curl -X POST -H "Content-Type:application/json" \

"https://api.enterprise.apigee.com/v1/organizations/myorg/environments/test/analytics/exports" \

-d \

'{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "json",

"datastoreName": "My Cloud Storage data repository"

}' \

-u orgAdminEmail:password

Verwenden Sie den im Attribut self angegebenen URI, um den Jobstatus zu überwachen, wie unter Status einer Analyseexportanfrage ansehen beschrieben.

Beispiel 2: Daten in BigQuery exportieren

Die folgende Anforderung exportiert eine durch Kommas getrennte CSV-Datei nach BigQuery:

curl -X POST -H "Content-Type:application/json" \

"https://api.enterprise.apigee.com/v1/organizations/myorg/environments/test/analytics/exports" \

-d \

'{

"name": "Export query results to BigQuery",

"description": "One-time export to BigQuery",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "csv",

"csvDelimiter": ",",

"datastoreName": "My BigQuery data repository"

}' \

-u orgAdminEmail:password

Hinweis: Die exportierte CSV-Datei erstellt eine BigQuery-Tabelle mit dem folgenden Präfix:

<PREFIX>_<EXPORT_DATE>_api_<UUID>_from_<FROM_DATE>_to_<TO_DATE>

Verwenden Sie den im Attribut self angegebenen URI, um den Jobstatus zu überwachen, wie unter Status einer Analyseexportanfrage ansehen beschrieben.

Beispiel 3: Monetarisierungsdaten exportieren

Wenn die Monetarisierung für eine Umgebung in der Organisation aktiviert ist, können Sie zwei Arten von Datenexporten ausführen:

- Standarddatenexport wie in den beiden vorherigen Beispielen.

- Export von Monetarisierungsdaten, um Daten speziell zur Monetarisierung zu exportieren.

Wenn du Monetarisierungsdaten exportieren möchtest, gib in der Nutzlast der Anfrage "dataset":"mint" an. Die Organisation und die Umgebung müssen die Monetarisierung unterstützen, um diese Option festzulegen. Andernfalls wird die dataset-Property in der Nutzlast nicht berücksichtigt:

'{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "json",

"datastoreName": "My Cloud Storage data repository",

"dataset":"mint"

}'Export-API-Kontingente

Edge setzt ein Kontingent für Aufrufe der /analytics/exports API durch, um eine übermäßige Verwendung von teuren API-Datenaufrufen für den Export zu vermeiden:

Für Organisationen und Umgebungen, für die die Monetarisierung nicht aktiviert ist, gilt das folgende Kontingent:

- 70 Aufrufe pro Monat pro Organisation und Umgebung.

Wenn Sie beispielsweise in Ihrer Organisation die beiden Umgebungen

produndtesthaben, können Sie für jede Umgebung 70 API-Aufrufe pro Monat ausführen.Für Organisationen und Umgebungen mit aktivierter Monetarisierung gilt das folgende Kontingent:

- 70 Aufrufe pro Monat für jede Organisation und Umgebung für Standarddaten

- 70 Aufrufe für jede Organisation und Umgebung für Monetarisierungsdaten.

Wenn Sie beispielsweise die Monetarisierung in Ihrer Organisation

prodaktivieren, können Sie 70 API-Aufrufe für Standarddaten und 70 zusätzliche API-Aufrufe für Monetarisierungsdaten ausführen.

Wenn Sie das Aufrufkontingent überschreiten, gibt die API den HTTP-Fehler 429 zurück.

Status aller Analyseexportanfragen anzeigen

Um den Status für alle Analyseexportanfragen aufzurufen, senden Sie eine GET-Anfrage an /analytics/exports.

Die folgende Anfrage gibt beispielsweise den Status aller Analyseexportanfragen für die Umgebung test in der Organisation myorg zurück:

curl -X GET \ "https://api.enterprise.apigee.com/v1/organizations/myorg/environments/test/analytics/exports" \ -u email:password

Im Folgenden finden Sie eine Beispielantwort, in der zwei Exportanfragen aufgeführt sind, eine (erstellte und) in die Warteschlange gestellte und eine abgeschlossene Anfrage:

[

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/e8b8db22-fe03-4364-aaf2-6d4f110444ba",

"name": "Export results To Cloud Storage",

"description": "One-time export to Google Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My Cloud Storage data store",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

},

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/9870987089fe03-4364-aaf2-6d4f110444ba"

"name": "Export raw results to BigQuery",

"description": "One-time export to BigQuery",

...

}

]

Status einer Analyseexportanforderung ansehen

Wenn Sie den Status einer bestimmten Analyseexportanfrage ansehen möchten, senden Sie eine GET-Anfrage an /analytics/exports/{exportId}, wobei {exportId} die ID ist, die der Analyseexportanfrage zugeordnet ist.

Die folgende Anfrage gibt beispielsweise den Status der Analyseexportanfrage mit der ID 4d6d94ad-a33b-4572-8dba-8677c9c4bd98 zurück.

curl -X GET \ "https://api.enterprise.apigee.com/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98" \ -u email:password

Im Folgenden finden Sie ein Beispiel für die Antwort:

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98",

"name": "Export results To Cloud Storage",

"description": "One-time export to Google Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My Cloud Storage data store",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

}

Wenn der Analyseexport keine Analysedaten zurückgibt, wird executionTime auf „0 Sekunden“ gesetzt.

Attributreferenz der Anforderung exportieren

In der folgenden Tabelle werden die Attribute beschrieben, die Sie im Anfragetext im JSON-Format übergeben können, wenn Sie Analysedaten exportieren.

| Attribut | Beschreibung | Erforderlich? |

|---|---|---|

description

|

Beschreibung der Exportanfrage. | Nein |

name

|

Name der Exportanfrage. | Ja |

dateRange

|

Geben Sie das

"dateRange": {

"start": "2018-07-29",

"end": "2018-07-30"

}Der Wert HINWEIS:Damit alle Daten des Vortags erfasst werden, müssen Sie möglicherweise die Startzeit der Exportanfrage verzögern (z. B. 00:05:00 Uhr UTC). |

Ja |

outputFormat

|

Geben Sie entweder json oder csv an.

|

Ja |

csvDelimiter

|

Trennzeichen in der CSV-Ausgabedatei, wenn |

Nein |

datastoreName

|

Der Name des Datenspeichers, der die Definition Ihres Datenspeichers enthält. | Ja |

Beispiel:

{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "json",

"datastoreName": "My Cloud Storage data repository"

}