Vous consultez la documentation d'Apigee Edge.

Accédez à la documentation sur Apigee X. info

Vous pouvez utiliser Edge Microgateway pour gérer les API Apigee pour les services exécutés dans un cluster Kubernetes. Cet article explique pourquoi vous pouvez souhaiter déployer Edge Microgateway sur Kubernetes et comment le faire en tant que service.

Cas d'utilisation

Les services déployés dans Kubernetes exposent généralement des API, que ce soit à des consommateurs externes ou à d'autres services exécutés dans le cluster.

Dans les deux cas, un problème important doit être résolu: comment allez-vous gérer ces API ? Exemple :

- Comment allez-vous les sécuriser ?

- Comment allez-vous gérer le trafic ?

- Comment allez-vous obtenir des insights sur les tendances du trafic, les latences et les erreurs ?

- Comment allez-vous publier vos API pour que les développeurs puissent les découvrir et les utiliser ?

Que vous migriez des services et des API existants vers la pile Kubernetes ou que vous créiez des services et des API, la micro passerelle Edge vous aide à bénéficier d'une expérience de gestion des API claire, qui inclut la sécurité, la gestion du trafic, l'analyse, la publication, etc.

Exécuter Edge Microgateway en tant que service

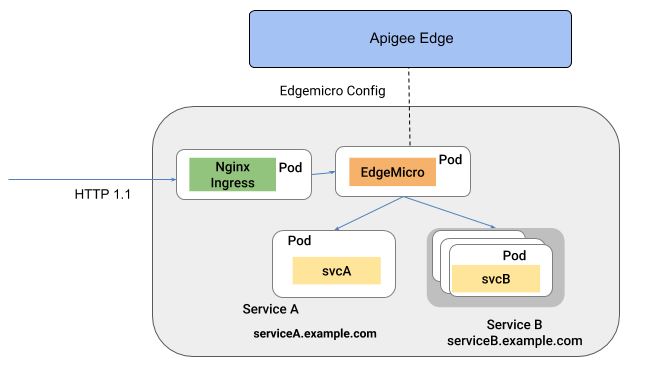

Lorsqu'il est déployé dans Kubernetes en tant que service, Edge Microgateway s'exécute dans son propre pod. Dans cette architecture, Edge Microgateway intercepte les appels d'API entrants et les achemine vers un ou plusieurs services cibles exécutés dans d'autres pods. Dans cette configuration, Edge Microgateway fournit aux autres services des fonctionnalités de gestion des API telles que la sécurité, l'analyse, la gestion du trafic et l'application des règles.

La figure suivante illustre l'architecture dans laquelle Edge Microgateway s'exécute en tant que service dans un cluster Kubernetes:

Consultez Déployer Edge Microgateway en tant que service dans Kubernetes.

Étape suivante

- Pour découvrir comment exécuter Edge Microgateway en tant que service dans Kubernetes, consultez Déployer Edge Microgateway en tant que service dans Kubernetes.