เอกสารนี้อธิบายวิธีเพิ่มศูนย์ข้อมูล (หรือที่เรียกว่าภูมิภาค) ลงในศูนย์ข้อมูลที่มีอยู่

ข้อควรพิจารณาก่อนเพิ่มศูนย์ข้อมูล

ก่อนที่จะติดตั้งหรือเพิ่มศูนย์ข้อมูล คุณต้องเข้าใจวิธีกำหนดค่าเซิร์ฟเวอร์ SymasLDAP, ZooKeeper, Cassandra และ Postgres ในศูนย์ข้อมูลต่างๆ นอกจากนี้ คุณต้องตรวจสอบว่าพอร์ตที่จำเป็นเปิดอยู่ระหว่างโหนดในศูนย์ข้อมูลทั้ง 2 แห่ง

- SymasLDAP

ศูนย์ข้อมูลแต่ละแห่งมีเซิร์ฟเวอร์ SymasLDAP ของตัวเองซึ่งได้รับการกำหนดค่าให้เปิดใช้การจำลอง เมื่อ ติดตั้งศูนย์ข้อมูลใหม่ คุณต้องกำหนดค่า SymasLDAP ให้ใช้การจำลอง และต้อง กำหนดค่าเซิร์ฟเวอร์ SymasLDAP ในศูนย์ข้อมูลที่มีอยู่ใหม่ให้ใช้การจำลอง

- ZooKeeper

สำหรับพร็อพเพอร์ตี้

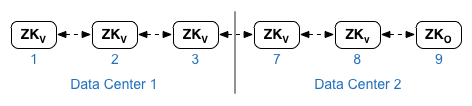

ZK_HOSTSของ ทั้ง 2 ศูนย์ข้อมูล ให้ระบุที่อยู่ IP หรือชื่อ DNS ของโหนด ZooKeeper ทั้งหมดจากทั้ง 2 ศูนย์ข้อมูลตามลำดับเดียวกัน และทำเครื่องหมายโหนดที่มีตัวแก้ไข ":observer" โหนดที่ไม่มีตัวแก้ไข:observerเรียกว่า "ผู้ลงคะแนน" คุณต้องมี "ผู้ลงคะแนน" จำนวนคี่ ในการกำหนดค่าในโทโพโลยีนี้ โฮสต์ ZooKeeper ในโฮสต์ 9 คือผู้สังเกตการณ์

ในไฟล์การกำหนดค่าตัวอย่างที่แสดงด้านล่าง โหนด 9 จะได้รับการติดแท็กด้วยตัวแก้ไข

:observerเพื่อให้คุณมีผู้ลงคะแนน 5 คน ได้แก่ โหนด 1, 2, 3, 7 และ 8สำหรับพร็อพเพอร์ตี้

ZK_CLIENT_HOSTSของศูนย์ข้อมูลแต่ละแห่ง ให้ระบุที่อยู่ IP หรือชื่อ DNS ของโหนด ZooKeeper ในศูนย์ข้อมูลเท่านั้น โดยเรียงตามลำดับเดียวกันสำหรับโหนด ZooKeeper ทั้งหมดในศูนย์ข้อมูล - Cassandra

สำหรับ

CASS_HOSTSในแต่ละศูนย์ข้อมูล ให้ตรวจสอบว่าคุณได้ระบุที่อยู่ IP ของ Cassandra ทั้งหมด (ไม่ใช่ชื่อ DNS) สำหรับทั้ง 2 ศูนย์ข้อมูล สำหรับศูนย์ข้อมูล 1 ให้แสดงรายการโหนด Cassandra ในศูนย์ข้อมูลนั้นก่อน สำหรับศูนย์ข้อมูล 2 ให้แสดงรายการโหนด Cassandra ในศูนย์ข้อมูลนั้นก่อน แสดงรายการโหนด Cassandra ในลำดับเดียวกัน สำหรับโหนด Cassandra ทั้งหมดในศูนย์ข้อมูลโหนด Cassandra ทั้งหมดต้องมีคำต่อท้าย ":d,r" เช่น "ip:1,1 = ศูนย์ข้อมูล 1 และแร็ก/เขตความพร้อมใช้งาน 1 และ "ip:2,1 = ศูนย์ข้อมูล 2 และแร็ก/เขตความพร้อมใช้งาน 1

เช่น "192.168.124.201:1,1 192.168.124.202:1,1 192.168.124.203:1,1 192.168.124.204:2,1 192.168.124.205:2,1 192.168.124.206:2,1"

ระบบจะใช้โหนดแรกในแร็ก/เขตความพร้อมใช้งาน 1 ของศูนย์ข้อมูลแต่ละแห่งเป็นเซิร์ฟเวอร์เริ่มต้น ในการติดตั้งใช้งานโมเดลนี้ การตั้งค่า Cassandra จะมีลักษณะดังนี้

-

Postgres

โดยค่าเริ่มต้น Edge จะติดตั้งโหนด Postgres ทั้งหมดในโหมดหลัก อย่างไรก็ตาม เมื่อมีศูนย์ข้อมูลหลายแห่ง คุณจะต้องกำหนดค่าโหนด Postgres ให้ใช้การจำลองแบบมาสเตอร์-สแตนด์บาย เพื่อให้หากโหนดมาสเตอร์ล้มเหลว โหนดสแตนด์บายจะยังคงให้บริการการรับส่งข้อมูลได้ โดยปกติแล้ว คุณจะกำหนดค่าเซิร์ฟเวอร์ Postgres หลักในศูนย์ข้อมูลหนึ่ง และเซิร์ฟเวอร์สแตนด์บายในศูนย์ข้อมูลที่สอง

หากมีการกำหนดค่าศูนย์ข้อมูลที่มีอยู่ให้มีโหนด Postgres 2 โหนดที่ทำงานในโหมดมาสเตอร์/สแตนด์บายอยู่แล้ว ให้ยกเลิกการลงทะเบียนโหนดสแตนด์บายที่มีอยู่และแทนที่ด้วยโหนดสแตนด์บายในศูนย์ข้อมูลใหม่ซึ่งเป็นส่วนหนึ่งของขั้นตอนนี้

ตารางต่อไปนี้แสดงการกำหนดค่า Postgres ก่อนและหลังสำหรับทั้ง 2 สถานการณ์

ก่อน หลัง โหนด Postgres หลักเดียวใน dc-1

โหนด Postgres หลักใน dc-1

โหนด Postgres แบบสแตนด์บายใน dc-2

โหนด Postgres หลักใน dc-1

โหนด Postgres สแตนด์บายใน dc-1

โหนด Postgres หลักใน dc-1

โหนด Postgres แบบสแตนด์บายใน dc-2

ยกเลิกการลงทะเบียนโหนด Standby Postgres เก่าใน dc-1

- ข้อกำหนดของพอร์ต

คุณต้องตรวจสอบว่าพอร์ตที่จำเป็นเปิดอยู่ระหว่างโหนดในศูนย์ข้อมูลทั้ง 2 แห่ง ดูแผนภาพพอร์ตได้ที่ข้อกำหนดของพอร์ต

การอัปเดตศูนย์ข้อมูลที่มีอยู่

การเพิ่มศูนย์ข้อมูลกำหนดให้คุณต้องทำตามขั้นตอนเพื่อติดตั้งและกำหนดค่าโหนดศูนย์ข้อมูลใหม่ แต่ก็กำหนดให้คุณต้องอัปเดตโหนดในศูนย์ข้อมูลเดิมด้วย การแก้ไขเหล่านี้จำเป็นเนื่องจากคุณกำลังเพิ่มโหนด Cassandra และ ZooKeeper ใหม่ในศูนย์ข้อมูลใหม่ ซึ่งต้องเข้าถึงได้จากศูนย์ข้อมูลที่มีอยู่ และคุณต้องกำหนดค่า SymasLDAP ใหม่เพื่อใช้การจำลอง

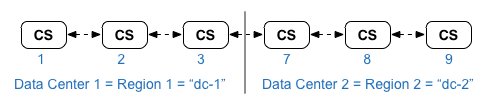

การสร้างไฟล์การกำหนดค่า

ด้านล่างนี้คือไฟล์การกำหนดค่าแบบเงียบสำหรับศูนย์ข้อมูล 2 แห่ง โดยแต่ละศูนย์ข้อมูลมี 6 โหนดตามที่แสดงในโทโพโลยีการติดตั้ง โปรดสังเกตว่าไฟล์การกำหนดค่าสำหรับ dc-1 จะเพิ่ม การตั้งค่าเพิ่มเติมไปยัง

- กำหนดค่า SymasLDAP ด้วยการจำลองแบบในโหนด SymasLDAP 2 โหนด

- เพิ่มโหนด Cassandra และ ZooKeeper ใหม่จาก dc-2 ลงในไฟล์กำหนดค่าสำหรับ dc-1

# Datacenter 1 IP1=IPorDNSnameOfNode1 IP2=IPorDNSnameOfNode2 IP3=IPorDNSnameOfNode3 IP7=IPorDNSnameOfNode7 IP8=IPorDNSnameOfNode8 IP9=IPorDNSnameOfNode9 HOSTIP=$(hostname -i) MSIP=$IP1 ADMIN_EMAIL=opdk@google.com APIGEE_ADMINPW=Secret123 LICENSE_FILE=/tmp/license.txt USE_LDAP_REMOTE_HOST=n LDAP_TYPE=2 LDAP_SID=1 LDAP_PEER=$IP7 APIGEE_LDAPPW=secret MP_POD=gateway-1 REGION=dc-1 ZK_HOSTS="$IP1 $IP2 $IP3 $IP7 $IP8 $IP9:observer" ZK_CLIENT_HOSTS="$IP1 $IP2 $IP3" # Must use IP addresses for CASS_HOSTS, not DNS names. CASS_HOSTS="$IP1:1,1 $IP2:1,1 $IP3:1,1 $IP7:2,1 $IP8:2,1 $IP9:2,1" SKIP_SMTP=n SMTPHOST=smtp.example.com SMTPUSER=smtp@example.com SMTPPASSWORD=smtppwd SMTPSSL=n SMTPPORT=25 SMTPMAILFROM="My Company <myco@company.com>" |

# Datacenter 2 IP1=IPorDNSnameOfNode1 IP2=IPorDNSnameOfNode2 IP3=IPorDNSnameOfNode3 IP7=IPorDNSnameOfNode7 IP8=IPorDNSnameOfNode8 IP9=IPorDNSnameOfNode9 HOSTIP=$(hostname -i) MSIP=$IP7 ADMIN_EMAIL=opdk@google.com APIGEE_ADMINPW=Secret123 LICENSE_FILE=/tmp/license.txt USE_LDAP_REMOTE_HOST=n LDAP_TYPE=2 LDAP_SID=2 LDAP_PEER=$IP1 APIGEE_LDAPPW=secret MP_POD=gateway-2 REGION=dc-2 ZK_HOSTS="$IP1 $IP2 $IP3 $IP7 $IP8 $IP9:observer" ZK_CLIENT_HOSTS="$IP7 $IP8 $IP9" # Must use IP addresses for CASS_HOSTS, not DNS names. CASS_HOSTS="$IP7:2,1 $IP8:2,1 $IP9:2,1 $IP1:1,1 $IP2:1,1 $IP3:1,1" SKIP_SMTP=n SMTPHOST=smtp.example.com SMTPUSER=smtp@example.com SMTPPASSWORD=smtppwd SMTPSSL=n SMTPPORT=25 SMTPMAILFROM="My Company <myco@company.com>" |

เพิ่มศูนย์ข้อมูลใหม่

ใช้ขั้นตอนด้านล่างเพื่อติดตั้งศูนย์ข้อมูลใหม่

ในกระบวนการนี้ ศูนย์ข้อมูลจะมีชื่อดังนี้

- dc-1: ศูนย์ข้อมูลที่มีอยู่

- dc-2: ศูนย์ข้อมูลใหม่

วิธีเพิ่มศูนย์ข้อมูลใหม่

- ใน dc-1 ให้เรียกใช้ setup.sh อีกครั้งในโหนด Cassandra เดิมด้วยไฟล์กำหนดค่า dc-1

ใหม่ซึ่งมีโหนด Cassandra จาก dc-2 ดังนี้

/opt/apigee/apigee-setup/bin/setup.sh -p ds -f configFile1

- ใน dc-1 ให้เรียกใช้ setup.sh อีกครั้งในโหนดเซิร์ฟเวอร์การจัดการ

/opt/apigee/apigee-setup/bin/setup.sh -p ms -f configFile1

หากคุณใช้การสร้างรายได้ ให้เรียกใช้คำสั่งการตั้งค่าการสร้างรายได้อีกครั้งโดยทำดังนี้

/opt/apigee/apigee-setup/bin/setup.sh -p mo -f mint_configFile1

- ใน dc-2 ให้ติดตั้ง

apigee-setupในทุกโหนด ดูข้อมูลเพิ่มเติมได้ที่ติดตั้งยูทิลิตี apigee-setup ของ Edge - ใน dc-2 ให้ติดตั้ง Cassandra และ ZooKeeper ในโหนดที่เหมาะสม

/opt/apigee/apigee-setup/bin/setup.sh -p ds -f configFile2

- ใน dc-2 ให้เรียกใช้คำสั่งสร้างใหม่ในโหนด Cassandra ทั้งหมด โดยระบุ

ชื่อภูมิภาคของ dc-1 ดังนี้

/opt/apigee/apigee-cassandra/bin/nodetool [-u username -pw password] -h cassIP rebuild dc-1

คุณต้องส่งชื่อผู้ใช้และรหัสผ่านก็ต่อเมื่อ เปิดใช้การตรวจสอบสิทธิ์ JMX สำหรับ Cassandra

- ใน dc-2 ให้ติดตั้งเซิร์ฟเวอร์การจัดการในโหนดที่เหมาะสมโดยทำดังนี้

/opt/apigee/apigee-setup/bin/setup.sh -p ms -f configFile2

- ในโหนดเซิร์ฟเวอร์การจัดการใน dc-2 ให้ติดตั้ง

apigee-provisionซึ่งจะติดตั้งยูทิลิตีapigee-adminapi.sh/opt/apigee/apigee-service/bin/apigee-service apigee-provision install

- ใน dc-2 ให้ติดตั้ง Routes และ Message Processors ในโหนดที่เหมาะสม

/opt/apigee/apigee-setup/bin/setup.sh -p rmp -f configFile2

- ใน dc-2 ให้ติดตั้ง Qpid ในโหนดที่เหมาะสม

/opt/apigee/apigee-setup/bin/setup.sh -p qs -f configFile2

- ใน dc-2 ให้ติดตั้ง Postgres ในโหนดที่เหมาะสมโดยทำดังนี้

/opt/apigee/apigee-setup/bin/setup.sh -p ps -f configFile2

- ตั้งค่ามาสเตอร์/สแตนด์บายของ Postgres สำหรับโหนด Postgres โหนด Postgres ใน dc-1 คือ

มาสเตอร์ และโหนด Postgres ใน dc-2 คือเซิร์ฟเวอร์สแตนด์บาย

- ในโหนดหลักใน dc-1 ให้แก้ไขไฟล์การกำหนดค่าเพื่อตั้งค่าต่อไปนี้

PG_MASTER=IPorDNSofDC1Master PG_STANDBY=IPorDNSofDC2Standby

- เปิดใช้การจำลองในมาสเตอร์ใหม่

/opt/apigee/apigee-service/bin/apigee-service apigee-postgresql setup-replication-on-master -f configFIle

- ในโหนดสแตนด์บายใน dc-2 ให้แก้ไขไฟล์การกำหนดค่าเพื่อตั้งค่าต่อไปนี้

PG_MASTER=IPorDNSofDC1Master PG_STANDBY=IPorDNSofDC2Standby

- ในโหนดสแตนด์บายใน dc-2 ให้หยุดเซิร์ฟเวอร์ แล้วลบข้อมูล Postgres ที่มีอยู่

ทั้งหมด

/opt/apigee/apigee-service/bin/apigee-service apigee-postgresql stop

rm -rf /opt/apigee/data/apigee-postgresql/หากจำเป็น คุณสามารถสำรองข้อมูลนี้ก่อนที่จะลบได้

- กำหนดค่าโหนดสแตนด์บายใน dc-2 ดังนี้

/opt/apigee/apigee-service/bin/apigee-service apigee-postgresql setup-replication-on-standby -f configFile

- ในโหนดหลักใน dc-1 ให้แก้ไขไฟล์การกำหนดค่าเพื่อตั้งค่าต่อไปนี้

- ใน dc-1 ให้อัปเดตการกำหนดค่าการวิเคราะห์และกำหนดค่าองค์กร

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้รับ UUID ของโหนด Postgres

ดังนี้

apigee-adminapi.sh servers list -r dc-1 -p analytics -t postgres-server \ --admin adminEmail --pwd adminPword --host localhost

UUID จะปรากฏที่ส่วนท้ายของข้อมูลที่ส่งคืน บันทึกค่านั้น

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-2 ให้รับ UUID ของโหนด Postgres ตามที่แสดงในขั้นตอนก่อนหน้า บันทึกค่านั้น

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้ระบุชื่อของกลุ่มการวิเคราะห์และกลุ่มผู้บริโภค

คำสั่งหลายรายการด้านล่างต้องใช้ข้อมูลดังกล่าว

โดยค่าเริ่มต้น ชื่อของกลุ่ม Analytics คือ "axgroup-001" และชื่อของกลุ่มผู้บริโภคคือ "consumer-group-001" ในไฟล์การกำหนดค่าแบบเงียบสำหรับภูมิภาค คุณสามารถตั้งชื่อ กลุ่มข้อมูลวิเคราะห์ได้โดยใช้พร็อพเพอร์ตี้

AXGROUPหากไม่แน่ใจเกี่ยวกับชื่อของกลุ่มข้อมูลวิเคราะห์และกลุ่มผู้บริโภค ให้ใช้คำสั่งต่อไปนี้เพื่อแสดงชื่อ

apigee-adminapi.sh analytics groups list \ --admin adminEmail --pwd adminPword --host localhost

คำสั่งนี้จะแสดงชื่อกลุ่มการวิเคราะห์ในช่องชื่อ และชื่อกลุ่มผู้บริโภค ในช่องกลุ่มผู้บริโภค

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้นําเซิร์ฟเวอร์ Postgres

ที่มีอยู่ออกจากกลุ่มข้อมูลวิเคราะห์โดยทำดังนี้

- นำโหนด Postgres ออกจากกลุ่มผู้ใช้

apigee-adminapi.sh analytics groups consumer_groups datastores remove \ -g axgroup-001 -c consumer-group-001 -u UUID \ -Y --admin adminEmail --pwd adminPword --host localhost

หากกำหนดค่า dc-1 ให้มีโหนด Postgres 2 รายการที่ทำงานใน โหมดมาสเตอร์/สแตนด์บาย ให้นำทั้ง 2 รายการออก

apigee-adminapi.sh analytics groups consumer_groups datastores remove \ -g axgroup-001 -c consumer-group-001 -u "UUID_1,UUID_2" \ -Y --admin adminEmail --pwd adminPword --host localhost

- นำโหนด Postgres ออกจากกลุ่มการวิเคราะห์

apigee-adminapi.sh analytics groups postgres_server remove \ -g axgroup-001 -u UUID -Y --admin adminEmail \ --pwd adminPword --host localhost

หากกำหนดค่า dc-1 ให้มีโหนด Postgres 2 โหนดที่ทำงานในโหมดหลัก/สแตนด์บาย ให้นำทั้ง 2 โหนดออก

apigee-adminapi.sh analytics groups postgres_server \ remove -g axgroup-001 -u UUID1,UUID2 -Y --admin adminEmail \ --pwd adminPword --host localhost

- นำโหนด Postgres ออกจากกลุ่มผู้ใช้

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้เพิ่มเซิร์ฟเวอร์ Postgres หลัก/สแตนด์บายใหม่ลงในกลุ่มข้อมูลวิเคราะห์

- เพิ่มเซิร์ฟเวอร์ Postgres ทั้ง 2 เครื่องลงในกลุ่มการวิเคราะห์

apigee-adminapi.sh analytics groups postgres_server \ add -g axgroup-001 -u "UUID_1,UUID_2" --admin adminEmail \ --pwd adminPword --host localhost

โดย UUID_1 สอดคล้องกับโหนด Postgres หลักใน dc-1 และ UUID_2 สอดคล้องกับโหนด Postgres สแตนด์บายใน dc-2

- เพิ่มเซิร์ฟเวอร์ PG ลงในกลุ่มผู้ใช้เป็นมาสเตอร์/สแตนด์บาย

apigee-adminapi.sh analytics groups consumer_groups datastores \ add -g axgroup-001 -c consumer-group-001 -u "UUID_1,UUID_2" --admin adminEmail \ --pwd adminPword --host localhost

- เพิ่มเซิร์ฟเวอร์ Postgres ทั้ง 2 เครื่องลงในกลุ่มการวิเคราะห์

- เพิ่มเซิร์ฟเวอร์ Qpid จาก dc-2 ลงในกลุ่มการวิเคราะห์โดยทำดังนี้

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้รับ UUID ของโหนด Qpid

ใน dc-2:

apigee-adminapi.sh servers list -r dc-2 -p central -t qpid-server \ --admin adminEmail --pwd adminPword --host localhost

UUID จะปรากฏที่ส่วนท้ายของข้อมูลที่แสดง บันทึกค่าเหล่านั้น

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้เพิ่มโหนด Qpid ลงใน

กลุ่มการวิเคราะห์ (เรียกใช้ทั้ง 2 คำสั่ง)

apigee-adminapi.sh analytics groups qpid_server \ add -g axgroup-001 -u "UUID_1" --admin adminEmail \ --pwd adminPword --host localhost

apigee-adminapi.sh analytics groups qpid_server \ add -g axgroup-001 -u "UUID_2" --admin adminEmail \ --pwd adminPword --host localhost - ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้เพิ่มโหนด Qpid ลงใน

กลุ่มผู้ใช้ (เรียกใช้ทั้ง 2 คำสั่ง)

apigee-adminapi.sh analytics groups consumer_groups consumers \ add -g axgroup-001 -c consumer-group-001 -u "UUID_1" \ --admin adminEmail --pwd adminPword --host localhost

apigee-adminapi.sh analytics groups consumer_groups consumers \ add -g axgroup-001 -c consumer-group-001 -u "UUID_2" \ --admin adminEmail --pwd adminPword --host localhostหากคุณใช้การสร้างรายได้ ให้เพิ่มโหนด Qpid ลงในกลุ่ม MINT ในโหนด Management Server ของ dc-1 โดยทำดังนี้

apigee-adminapi.sh analytics groups qpid_server \ add -g mxgroup001 -u UUID_1 --admin adminEmail \ --pwd adminPword --host localhost

apigee-adminapi.sh analytics groups qpid_server \ add -g mxgroup001 -u UUID_2 --admin adminEmail \ --pwd adminPword --host localhost

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้รับ UUID ของโหนด Qpid

ใน dc-2:

- ยกเลิกการลงทะเบียนและลบเซิร์ฟเวอร์สแตนด์บาย Postgres เก่าออกจาก dc-1:

- ยกเลิกการลงทะเบียนเซิร์ฟเวอร์สแตนด์บาย Postgres dc-1 ที่มีอยู่

apigee-adminapi.sh servers deregister -u UUID -r dc-1 \ -p analytics -t postgres-server -Y --admin adminEmail \ --pwd adminPword --host localhost

โดย UUID คือโหนด Postgres แบบสแตนด์บายเดิมใน dc-1

- ลบเซิร์ฟเวอร์สแตนด์บาย Postgres dc-1 ที่มีอยู่

apigee-adminapi.sh servers delete -u UUID \ --admin adminEmail --pwd adminPword --host localhost

- ยกเลิกการลงทะเบียนเซิร์ฟเวอร์สแตนด์บาย Postgres dc-1 ที่มีอยู่

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้รับ UUID ของโหนด Postgres

ดังนี้

- อัปเดตคีย์สเปซ Cassandra ด้วยปัจจัยการจำลองที่ถูกต้องสำหรับศูนย์ข้อมูลทั้ง 2 แห่ง คุณ

ต้องเรียกใช้ขั้นตอนนี้เพียงครั้งเดียวในเซิร์ฟเวอร์ Cassandra ใดก็ได้ในศูนย์ข้อมูลใดศูนย์ข้อมูลหนึ่ง

- เริ่มยูทิลิตี

cqlshCassandra โดยทำดังนี้/opt/apigee/apigee-cassandra/bin/cqlsh cassandraIP

- เรียกใช้คำสั่ง CQL ต่อไปนี้ที่พรอมต์ "cqlsh>" เพื่อตั้งค่าระดับการจำลองสำหรับคีย์สเปซ Cassandra

ALTER KEYSPACE "identityzone" WITH replication = { 'class': 'NetworkTopologyStrategy', 'dc-1': '3','dc-2': '3' };ALTER KEYSPACE "system_traces" WITH replication = { 'class': 'NetworkTopologyStrategy', 'dc-1': '3','dc-2': '3' };- ดูคีย์สเปซโดยใช้คำสั่งต่อไปนี้

SELECT * FROM system_schema.keyspaces;

- ทางออก

cqlsh:exit

- เริ่มยูทิลิตี

- เรียกใช้คำสั่ง

nodetoolต่อไปนี้ในโหนด Cassandra ทั้งหมดใน dc-1 เพื่อเพิ่ม หน่วยความจำ/opt/apigee/apigee-cassandra/bin/nodetool [-u username -pw password] -h cassandraIP cleanup

คุณต้องส่งชื่อผู้ใช้และรหัสผ่านก็ต่อเมื่อ เปิดใช้การตรวจสอบสิทธิ์ JMX สำหรับ Cassandra

- สำหรับแต่ละองค์กรและแต่ละสภาพแวดล้อมที่คุณต้องการรองรับในศูนย์ข้อมูล ให้ทำดังนี้

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้เพิ่ม MP_POD ใหม่ลงใน

องค์กร

apigee-adminapi.sh orgs pods add -o orgName -r dc-2 -p gateway-2 \ --admin adminEmail --pwd adminPword --host localhost

โดย gateway-2 คือชื่อของพ็อดเกตเวย์ตามที่กำหนดโดย พร็อพเพอร์ตี้ MP_POD ในไฟล์กำหนดค่า dc-2

- เพิ่ม Message Processor ใหม่ลงในองค์กรและสภาพแวดล้อมโดยทำดังนี้

- ในโหนด Management Server ของ dc-2 ให้รับ UUID ของ

โหนด Message Processor ใน dc-2 โดยทำดังนี้

apigee-adminapi.sh servers list -r dc-2 -p gateway-2 \ -t message-processor --admin adminEmail --pwd adminPword --host localhost

UUID จะปรากฏที่ส่วนท้ายของข้อมูลที่แสดง บันทึกค่าเหล่านั้น

- ในโหนด Management Server ของ dc-1 ให้เพิ่ม Message Processor ลงในสภาพแวดล้อมขององค์กรสำหรับ Message Processor แต่ละรายการ

ใน dc-2 โดยทำดังนี้

apigee-adminapi.sh orgs envs servers add -o orgName -e envName \ -u UUID --admin adminEmail --pwd adminPword --host localhost

- ในโหนด Management Server ของ dc-2 ให้รับ UUID ของ

โหนด Message Processor ใน dc-2 โดยทำดังนี้

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้ตรวจสอบองค์กรดังนี้

apigee-adminapi.sh orgs apis deployments -o orgName -a apiProxyName \ --admin adminEmail --pwd adminPword --host localhost

โดยที่ apiProxyName คือชื่อของพร็อกซี API ที่ทําให้ใช้งานได้ในองค์กร

- ในโหนดเซิร์ฟเวอร์การจัดการของ dc-1 ให้เพิ่ม MP_POD ใหม่ลงใน

องค์กร

หากคุณใช้การสร้างรายได้ ให้ติดตั้งโหนดการสร้างรายได้ใน DC2

เรียกใช้คำสั่งการตั้งค่า MINT ในเซิร์ฟเวอร์การจัดการและโหนดตัวประมวลผลข้อความใน DC2

/opt/apigee/apigee-setup/bin/setup.sh -p mo -f mint_configFile1