Wyświetlasz dokumentację Apigee Edge.

Otwórz dokumentację Apigee X. Informacje

Edge Microgateway w wersji 3.2.x

Apigee Edge Microgateway to bezpieczny procesor wiadomości dla interfejsów API oparty na protokole HTTP. Jego główne zadanie polega na bezpiecznym przetwarzaniu żądań i odpowiedzi wysyłanych do usług backendowych i zwrotnych, a także asynchronicznym przesyłaniu cennych danych o wykonywaniu interfejsu API do Apigee Edge, gdzie są one wykorzystywane przez system Edge Analytics. Edge Microgateway jest łatwy w instalacji i wdrożeniu – instancję można uruchomić w kilka minut.

Edge Microgateway jest zwykle instalowany w zaufanej sieci w pobliżu usług docelowych w backendzie. Zapewnia ona zabezpieczenia klasy korporacyjnej oraz niektóre kluczowe funkcje wtyczki, takie jak zapobieganie wzrostom, limity i statystyki, ale nie zapewnia pełnych możliwości ani śladu Apigee Edge. Jeśli chcesz, możesz zainstalować Edge Microgateway w tym samym centrum danych lub nawet na tym samym komputerze co usługi backendowe.

Edge Microgateway możesz uruchomić jako samodzielny proces lub w kontenerze Dockera. Zobacz Korzystanie z Dockera z Edge Microgateway. Możesz też użyć Edge Microgateway do zarządzania interfejsami API Apigee w przypadku usług działających w klastrze Kubernetes. Niezależnie od tego, czy migrujesz istniejące usługi i interfejsy API do platformy Kubernetes, czy tworzysz nowe usługi i interfejsy API, Edge Microgateway zapewnia przejrzyste zarządzanie interfejsami API, w tym bezpieczeństwo, zarządzanie ruchem, analizę, publikowanie i inne funkcje. Zapoznaj się z artykułem Integracja Edge Microgateway z Kubernetes.

Typowe przypadki użycia

Typowe przypadki użycia hybrydowego rozwiązania do zarządzania interfejsami Cloud API, takiego jak Edge Microgateway:

- Zmniejszenie opóźnień ruchu API w przypadku usług działających w bliskiej odległości. Jeśli na przykład użytkownicy i producenci interfejsu API znajdują się w pobliżu, niekoniecznie chcesz, aby interfejsy API przechodziły przez bramę centralną.

- Przekazywanie ruchu API w ramach granic zatwierdzonych przez firmę w celu zapewnienia bezpieczeństwa lub zgodności z wymaganiami.

- kontynuować przetwarzanie wiadomości, jeśli połączenie z internetem zostanie tymczasowo utracone;

- Zarządzanie interfejsami API Apigee w przypadku usług działających w klastrze Kubernetes. Zapoznaj się z artykułem Integracja Edge Microgateway z Kubernetes.

Więcej zastosowań znajdziesz w tym artykule w społeczności Apigee.

Najważniejsze funkcje i zalety

| Funkcja | Zalety |

|---|---|

| Bezpieczeństwo | Edge Microgateway uwierzytelnia żądania za pomocą podpisanego tokena dostępu lub klucza interfejsu API wydanego przez Apigee Edge każdej aplikacji klienckiej. |

| Szybkie wdrażanie | W przeciwieństwie do pełnego wdrożenia Apigee Edge, instancję Edge Microgateway można wdrożyć i uruchomić w ciągu kilku minut. |

| Odległość w sieci | Edge Microgateway można zainstalować i nim zarządzać na tym samym urządzeniu, podsieci lub w tym samym centrum danych co docelowe interfejsy API backendu, z którymi Edge Microgateway się komunikuje. |

| Analityka | Edge Microgateway asynchronicznie przesyła dane dotyczące wykonania interfejsu API do Apigee Edge, gdzie są one przetwarzane przez system Edge Analytics. Możesz korzystać z pełnego zestawu danych, paneli i interfejsów API Edge Analytics. |

| mniejsze opóźnienia, | Cała komunikacja z Apigee Edge jest asynchroniczna i nie odbywa się w ramach przetwarzania żądań interfejsu API klienta. Dzięki temu Edge Microgateway może zbierać dane interfejsu API i przesyłać je do Apigee Edge bez wpływu na opóźnienie. |

| Znajomość | Edge Microgateway korzysta z funkcji Apigee Edge i współdziała z nimi, ponieważ administratorzy Edge znają już dobrze takie funkcje, jak proxy, produkty i aplikacje dla deweloperów. |

| Konfiguracja | Konfiguracja i zarządzanie Edge Microgateway nie wymagają umiejętności programowania. Wszystko jest obsługiwane przez konfigurację. |

| Próba dogodna | Edge Microgateway można zintegrować z istniejącą infrastrukturą i procesami monitorowania oraz zarządzania aplikacjami. Pamiętaj, że monitorowanie interfejsu API Apigee nie jest obsługiwane w przypadku Edge Microgateway. |

| Logowanie | Pliki dziennika zawierają szczegółowe informacje o wszystkich typowych i wyjątkowych zdarzeniach napotkanych podczas przetwarzania interfejsu API przez Edge Microgateway. |

| interfejs CLI | Interfejs wiersza poleceń umożliwia uruchamianie, zatrzymywanie i ponowne uruchamianie Edge Microgateway, wyodrębnianie statystyk operacyjnych, wyświetlanie plików logów, żądanie tokenów dostępu i wiele innych czynności. |

Co musisz wiedzieć o Edge Microgateway

W tej sekcji opisaliśmy, jak działa Edge Microgateway, jego podstawową architekturę, konfigurację i wdrażanie.

Dlaczego warto korzystać z Edge Microgateway?

Przeniesienie komponentu zarządzania interfejsem API bliżej aplikacji docelowych w backendzie może skrócić czas oczekiwania w sieci. Chociaż możesz zainstalować Apigee Edge lokalnie w chmurze prywatnym, pełne wdrożenie Apigee Edge musi być duże i złożone, aby obsługiwać pełny zestaw funkcji i obsługiwać funkcje o dużym natężeniu danych, takie jak zarządzanie kluczami, zarabianie i statystyki. Oznacza to, że wdrażanie Apigee Edge w pomieszczeniach w każdym centrum danych nie zawsze jest pożądane.

Edge Microgateway to aplikacja o stosunkowo niewielkim rozmiarze, która działa blisko aplikacji backendowych. Możesz też korzystać z pełnych możliwości Apigee Edge w zakresie analiz, zabezpieczeń i innych funkcji.

Przykładowe scenariusze wdrożenia

Ta sekcja przedstawia kilka możliwych scenariuszy wdrożenia mikrobramki Edge.

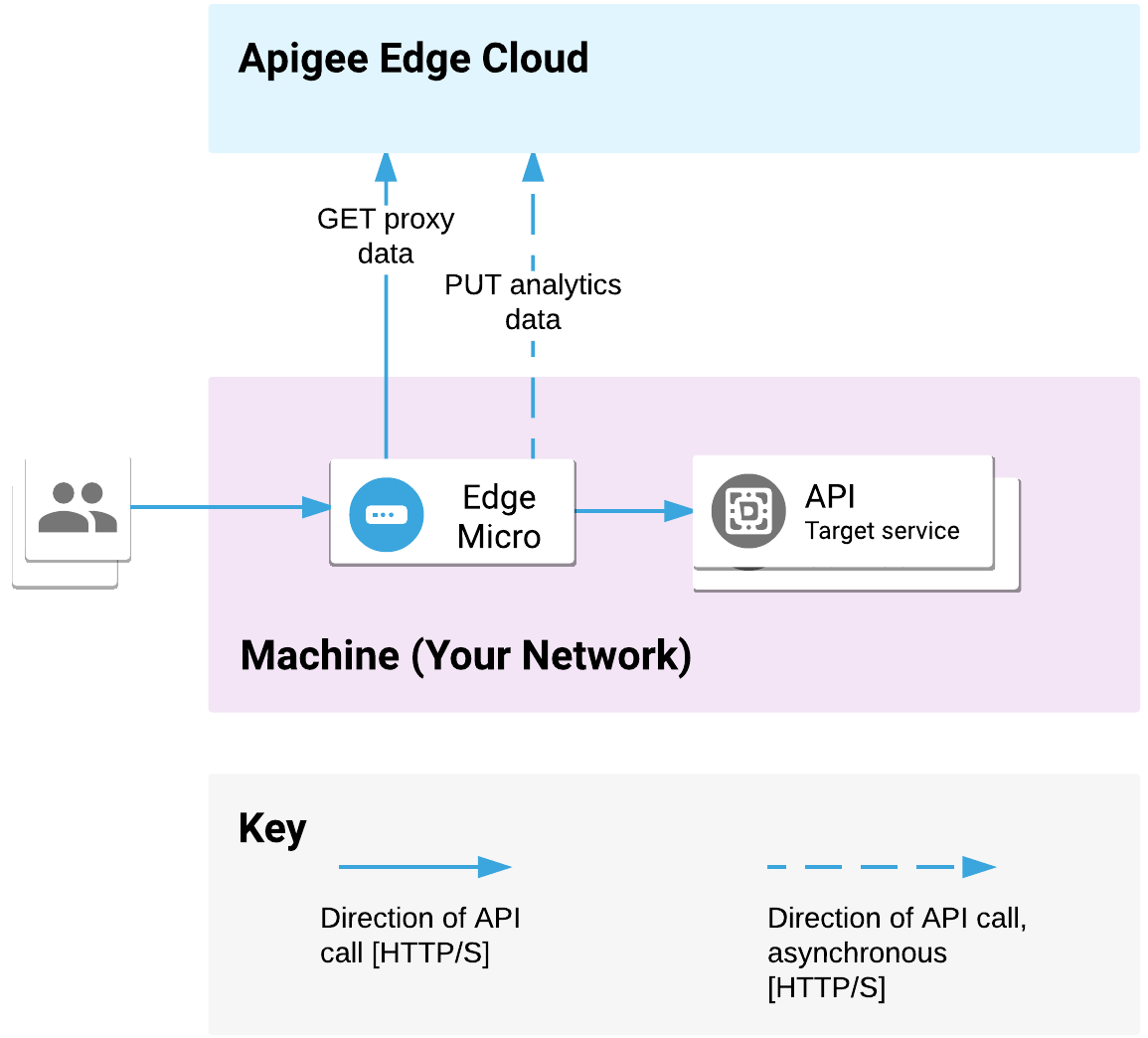

Ten sam komputer

Rysunek 1 przedstawia ścieżkę przetwarzania żądania, gdy Edge Microgateway jest wdrożony w najprostszej możliwej konfiguracji, w której Edge Microgateway i back-endowe interfejsy API są instalowane na tym samym urządzeniu. Jedna instancja Edge Microgateway może służyć do obsługi wielu aplikacji docelowych w systemie backend

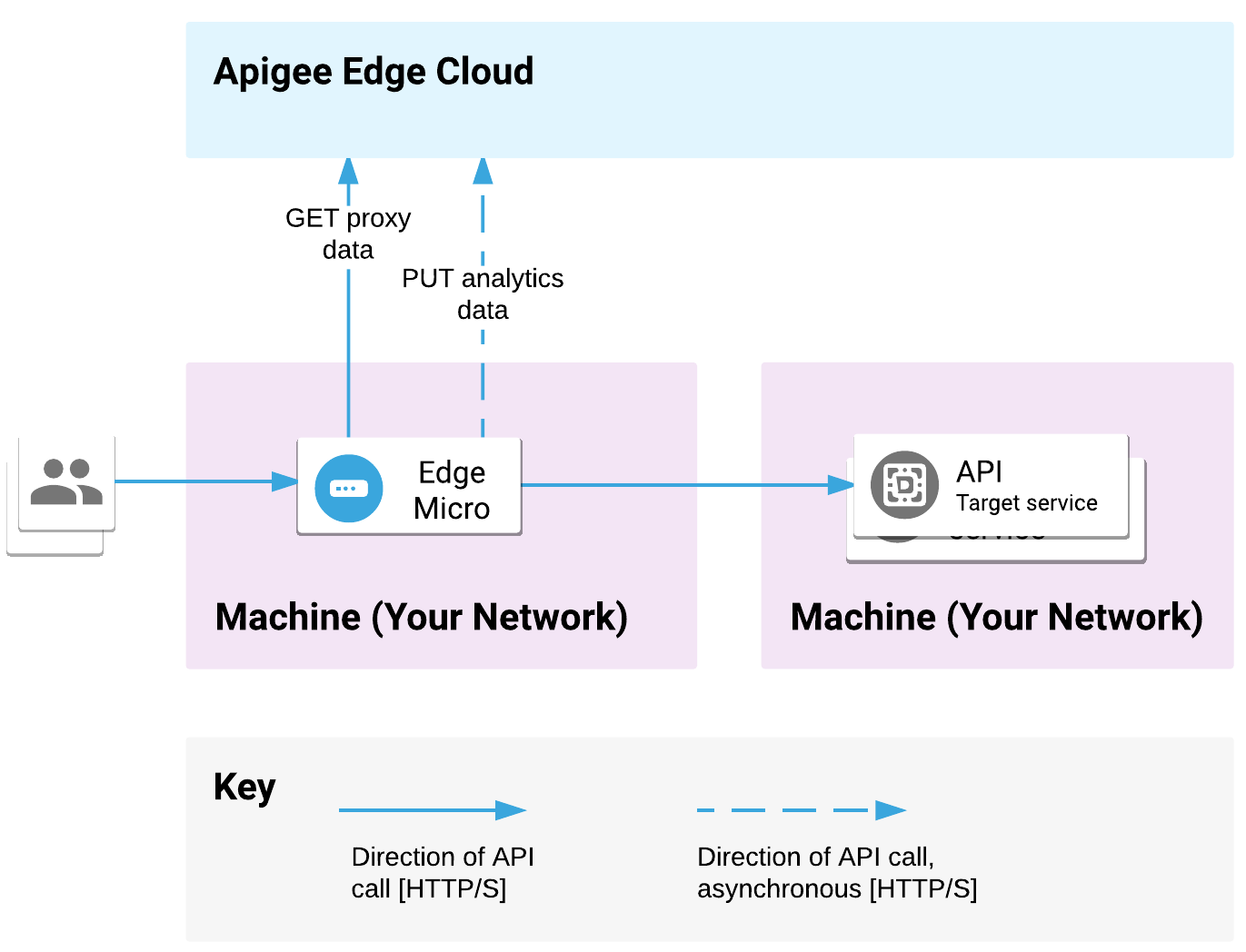

Inna maszyna

Ponieważ cała komunikacja między klientami, Edge Microgateway i implementacjami interfejsu API w backendzie odbywa się w protokole HTTP, możesz zainstalować Edge Microgateway Apigee na innym komputerze niż ten, na którym znajduje się implementacja interfejsu API, jak pokazano na rysunku 2.

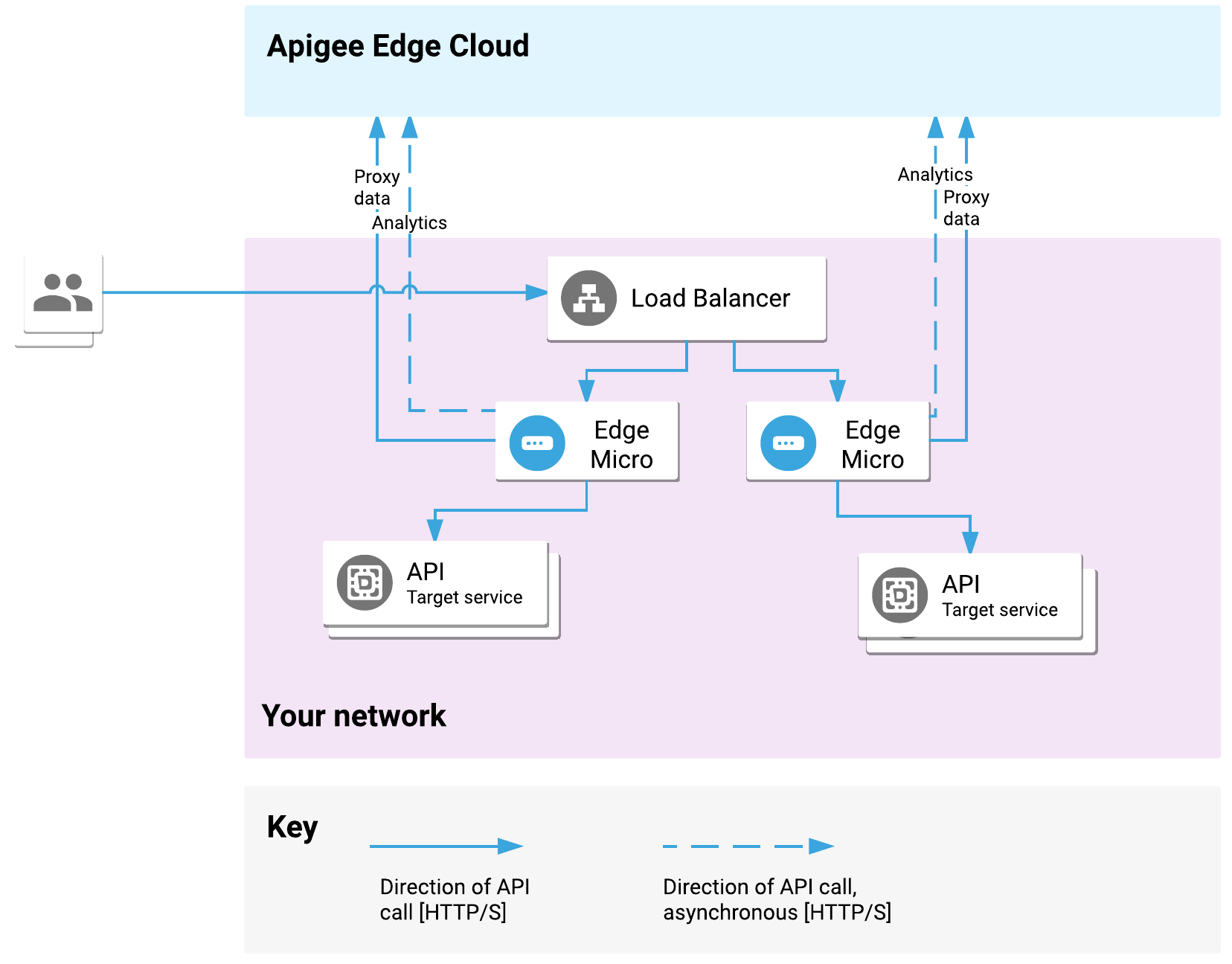

Z systemem równoważenia obciążenia

Edge Microgateway może być używany jako front-end dla standardowego serwera proxy odwrotnego lub systemu równoważenia obciążenia w celu zakończenia SSL lub równoważenia obciążenia, jak pokazano na rysunku 3.

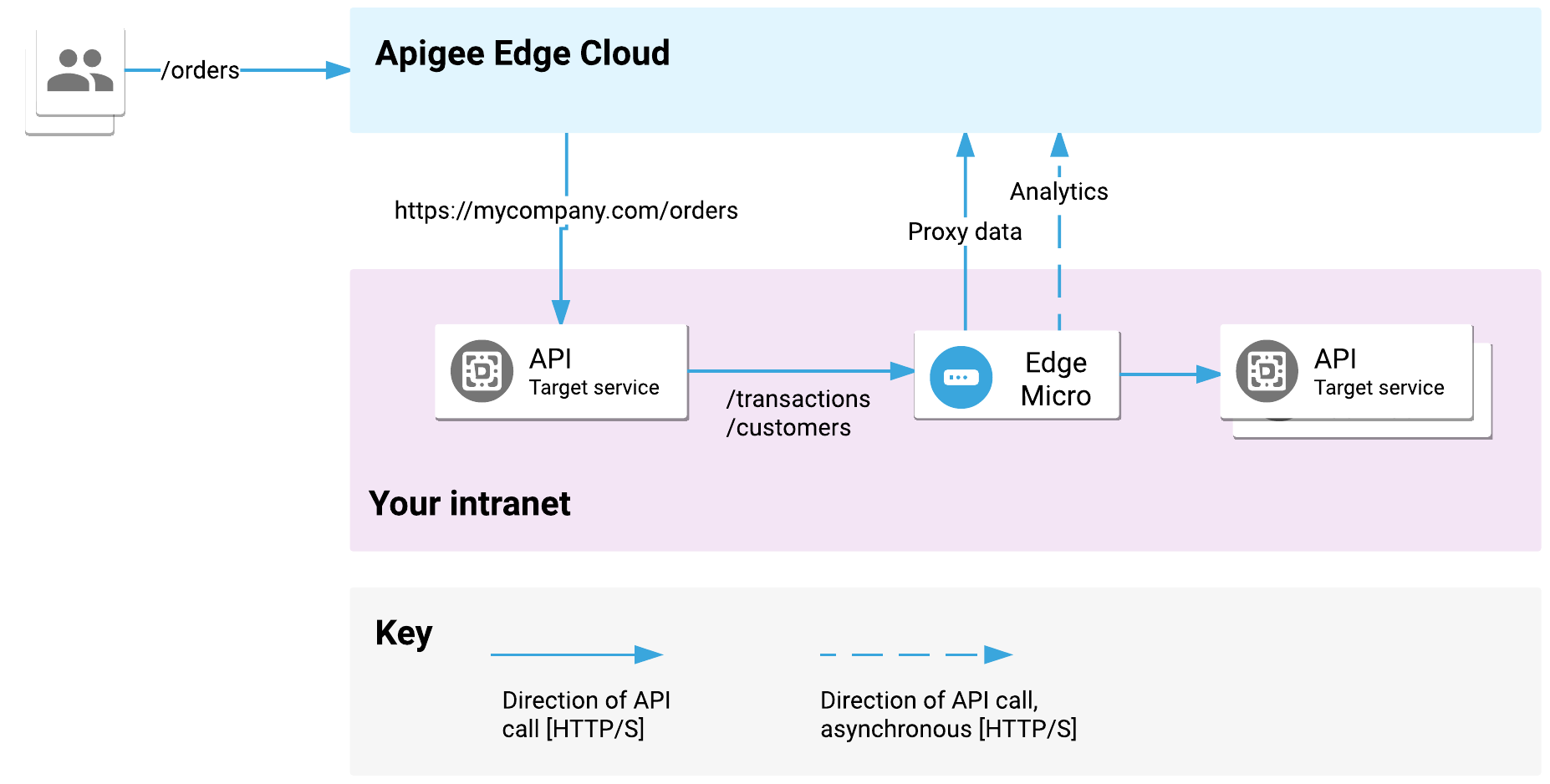

Wdrożenie w intranetach

Użyj Edge Microgateway do ochrony ruchu w intranetach, a do ochrony ruchu w internecie użyj Apigee Edge, jak pokazano na rysunku 4. Załóżmy, że punkt końcowy interfejsu API /orders jest obsługiwany przez Apigee Edge Cloud i trafia do celu w backendzie https://mycompany.com/orders. Jest ono reprezentowane przez implementację docelowego interfejsu API po lewej stronie. Ten interfejs API może wywoływać wiele punktów końcowych interfejsu API reprezentowanych przez implementację docelową po prawej stronie. Może na przykład wywoływać wewnętrznie funkcje /customers i /transactions. Zobacz też

ten post w społeczności Apigee.

Zależność od Apigee Edge

Edge Microgateway zależy od Apigee Edge i współdziała z tą usługą. Aby prawidłowo działać, Edge Microgateway musi komunikować się z Apigee Edge. Główne sposoby interakcji Edge Microgateway z Edge:

- Po uruchomieniu Edge Microgateway uzyskuje listę specjalnych proxy „Edge Microgateway-aware” oraz listę wszystkich usług API z organizacji Apigee Edge. W przypadku każdego przychodzącego żądania klienta Edge Microgateway sprawdza, czy żądanie pasuje do jednego z tych interfejsów API, a następnie weryfikuje przychodzący token dostępu lub klucz interfejsu API na podstawie kluczy w produkcie interfejsu API powiązanym z tym interfejsem API.

- System Apigee Edge Analytics przechowuje i przetwarza dane interfejsu API wysyłane asynchronicznie z mikrobramki Edge.

- Apigee Edge udostępnia dane logowania służące do podpisywania tokenów dostępu lub kluczy API, które są wymagane przez klientów wykonujących wywołania interfejsu API za pomocą mikrobramki Edge. Możesz je uzyskać, używając polecenia wiersza poleceń udostępnionego przez Edge Microgateway.

Konfiguracja jednorazowa

Aby Edge Microgateway mógł komunikować się z organizacją Apigee Edge, musisz go najpierw skonfigurować. Podczas uruchamiania Edge Microgateway inicjuje operację uruchamiania za pomocą Apigee Edge. Edge Microgateway pobiera z Apigee Edge informacje, których potrzebuje do przetwarzania wywołań interfejsu API, w tym listę serwerów proxy obsługujących Edge Microgateway, które są wdrażane w Apigee Edge. Wkrótce omówimy te serwery proxy.

Edge Microgateway nie musi znajdować się w tym samym miejscu co Apigee Edge. Oferty Apigee Edge w chmurze publicznej i prywatnej działają równie dobrze.

Co musisz wiedzieć o przekierowaniach obsługujących Edge Microgateway

Serwery proxy obsługujące Edge Microgateway udostępniają Edge Microgateway określone informacje, które umożliwiają przetwarzanie żądań interfejsu API klienta. Informacje o tych serwerach proxy są pobierane z Apigee Edge do Edge Microgateway, gdy ten ostatni uruchamia się.

Ty lub Twój zespół ds. interfejsu API musicie utworzyć te serwery proxy w usłudze Apigee Edge za pomocą interfejsu zarządzania Apigee Edge lub w inny sposób. To proste. Szczegółowe instrukcje znajdziesz w artykule Konfigurowanie i konfigurowanie Edge Microgateway.

Cechy serwerów proxy obsługujących Edge Microgateway:

- Przekazują one mikrobramie Edge 2 kluczowe informacje: ścieżkę podstawową i docelowy adres URL.

- Muszą one wskazywać docelowe punkty końcowe HTTP. Docelowy backend nie może być aplikacją Node.js, do której odwołuje się element ScriptTarget w definicji punktu docelowego. Więcej informacji znajdziesz w poprzedniej notatce.

- Nazwy serwerów proxy muszą być poprzedzone ciągiem

edgemicro_. Na przykład:edgemicro_weather. - Do tych serwerów proxy nie możesz dodawać reguł ani przepływów warunkowych. Jeśli spróbujesz to zrobić, zostaną one zignorowane. W przeciwnym razie proxy obsługujące Edge Microgateway są widoczne w interfejsie zarządzania Edge tak samo jak inne proxy interfejsu API w Edge.

- Można je łączyć w pakiety z produktami i aplikacjiami deweloperów.

- Dane o ruchu pojawiają się w Edge Analytics.

- Nie można ich śledzić za pomocą narzędzia Apigee Edge Trace.

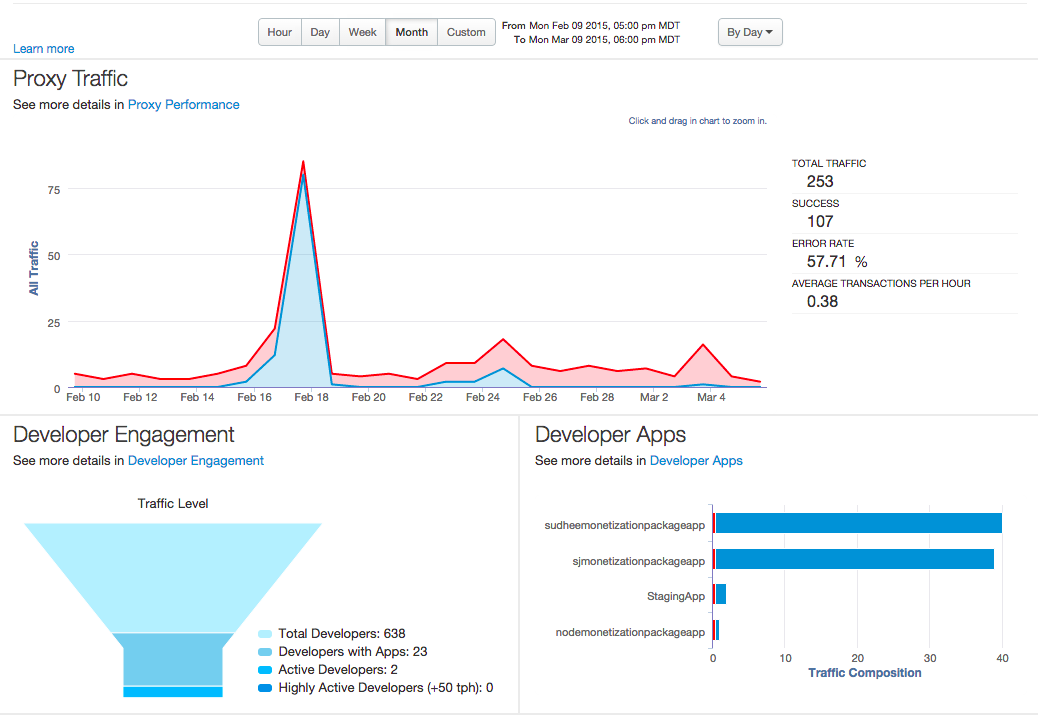

Edge Microgateway i Apigee Edge Analytics

Gdy ruch API przepływa przez Edge Microgateway, Edge Microgateway buforuje i asymetrycznie wysyła dane dotyczące wykonania interfejsu API do Apigee Edge, gdzie są one przechowywane i przetwarzane przez system Edge Analytics. Ta asynchroniczna komunikacja umożliwia urządzeniu Edge Microgateway korzystanie z funkcji analitycznych Edge przy jednoczesnym zachowaniu stosunkowo niewielkiego śladu i minimalnego obciążenia procesora lub blokowania. Ty i Twój zespół możecie korzystać z pełnego zestawu paneli Edge Analytics i funkcji raportowania niestandardowego, aby analizować ruch przechodzący przez Edge Microgateway.

Więcej informacji o Edge Analytics znajdziesz na panelach Analytics.

Informacje o Edge Bezpieczeństwo mikrobramki

Rola Apigee Edge

Jak już wspomnieliśmy, Apigee Edge odpowiada za zabezpieczenie wszystkich żądań klientów wysyłanych do Edge Microgateway. Główne role Apigee Edge to:

- Przekazywanie danych logowania klienta, które są używane jako klucze interfejsu API lub do generowania prawidłowych tokenów dostępu używanych przez klientów do bezpiecznego wywoływania interfejsów API przez Edge Microgateway.

- Przekazanie danych logowania, których Edge Microgateway potrzebuje do wysyłania danych o wykonaniu interfejsu API do systemu Edge Analytics w usłudze Apigee. Te dane logowania są pobierane raz przez Edge Microgateway podczas początkowych kroków konfiguracji.

- udostępnianie platformy do grupowania zasobów interfejsu API w produkty, rejestrowanie deweloperów i zarządzanie nimi oraz tworzenie aplikacji dla deweloperów i zarządzanie nimi.

Uwierzytelnianie aplikacji klienta

Edge Microgateway obsługuje uwierzytelnianie klienta za pomocą tokenów dostępu i kluczy interfejsu API. Klucze bezpieczeństwa i tokeny są generowane przez Apigee Edge i weryfikowane przez Edge Microgateway w przypadku każdego wywołania interfejsu API. Jeśli wtyczka OAuth jest włączona, Edge Microgateway sprawdza podpisany token dostępu lub klucz API. Jeśli jest prawidłowy, wywołanie interfejsu API przechodzi do celu w back-endzie. Jeśli nie jest prawidłowy, zwracany jest błąd.

Więcej informacji o krokach potrzebnych do uzyskania i używania tokenów dostępu oraz kluczy API znajdziesz w artykule Konfigurowanie i uruchamianie Edge Microgateway.

Uwierzytelnianie w Edge Microgateway w Apigee Edge

Wywołania asynchroniczne, które Edge Microgateway wykonuje, aby aktualizować dane analityczne w Apigee Edge, wymagają uwierzytelnienia. Uwierzytelnianie odbywa się za pomocą pary kluczy publicznych i prywatnych przekazywanych do Edge Microgateway za pomocą interfejsu wiersza poleceń lub zmiennych środowiskowych. Te klucze uzyskujesz i używasz raz, gdy po raz pierwszy instalujesz i uruchamiasz Edge Microgateway.

Platforma do zarządzania usługami API

Edge to platforma do grupowania zasobów interfejsu API w produkty, rejestrowania programistów i zarządzania nimi oraz tworzenia aplikacji dla programistów i nimi zarządzania. Podobnie jak w przypadku zwykłych serwerów proxy Apigee Edge możesz tworzyć i związywać w pakiety elementy takie jak produkty i aplikacje dla deweloperów. To samo możesz zrobić w przypadku serwerów proxy Edge Microgateway. Bezpieczeństwo na poziomie interfejsu API jest możliwe dzięki wygenerowaniu publicznych i prywatnych kluczy bezpieczeństwa dla każdego „pakietu”. Ten mechanizm jest identyczny z sposobem działania zabezpieczeń interfejsu API w usłudze Apigee Edge.

Czy mogę przenieść istniejące implementacje proxy w Edge do Edge Microgateway?

Nie można przenieść do Edge Microgateway istniejących serwerów proxy z powiązanymi zasadami lub warunkowymi przepływami danych. Edge Microgateway wymaga utworzenia nowych „obsługujących mikrobramę” serwerów proxy. Te serwery proxy muszą mieć nazwy z specjalnym prefiksem edgemicro_. Po uruchomieniu bramka Edge Microgateway wykrywa te serwery proxy edgemicro_* i pobiera informacje o konfiguracji dotyczące każdego z nich. Te informacje obejmują adresy URL docelowe i ścieżki zasobów. Od tego momentu serwery proxy nie są używane. Żadne zasady ani przepływy warunkowe w tych serwerach proxy nigdy się nie wykonają.

Kolejnym powodem, dla którego warto mieć serwery proxy obsługujące mikrobramki, jest to, że Edge Microgateway asynchronicznie przesyła dane analityczne do Edge w przypadku każdego serwera proxy obsługującego mikrobramki. Następnie możesz wyświetlać dane analityczne dotyczące serwerów proxy obsługujących mikrobramki tak samo jak w przypadku innych serwerów proxy w interfejsie Analytics w Edge.

W temacie konfiguracji znajdziesz wszystkie instrukcje, które pomogą Ci rozpocząć przekierowywanie wywołań interfejsu API przez Edge Microgateway. Obejmują one kilka prostych kroków, które musisz wykonać w Apigee Edge, aby skonfigurować konfigurację wymaganą przez Edge Microgateway, w tym utworzyć odpowiednie serwery proxy. Zobacz artykuł Konfigurowanie i konfigurowanie Edge Microgateway.

Więcej informacji o Edge Microgateway

Apigee udostępnia te zasoby:

-

Dokumentacja Edge Microgateway – zawiera przewodnik instalacyjny i samouczek, a także pełne informacje referencyjne i konfiguracyjne.

-

Filmy: seria filmów „4-minutowe filmy dla programistów” firmy Apigee zawiera kilka odcinków poświęconych bramce Edge Microgateway.

-

Społeczność Apigee to świetne miejsce do zadawania pytań i korzystania z pytań zadawanych i otrzymywania odpowiedzi na nie od innych osób.