Przeglądasz dokumentację Apigee Edge.

Przejdź do

Dokumentacja Apigee X. informacje.

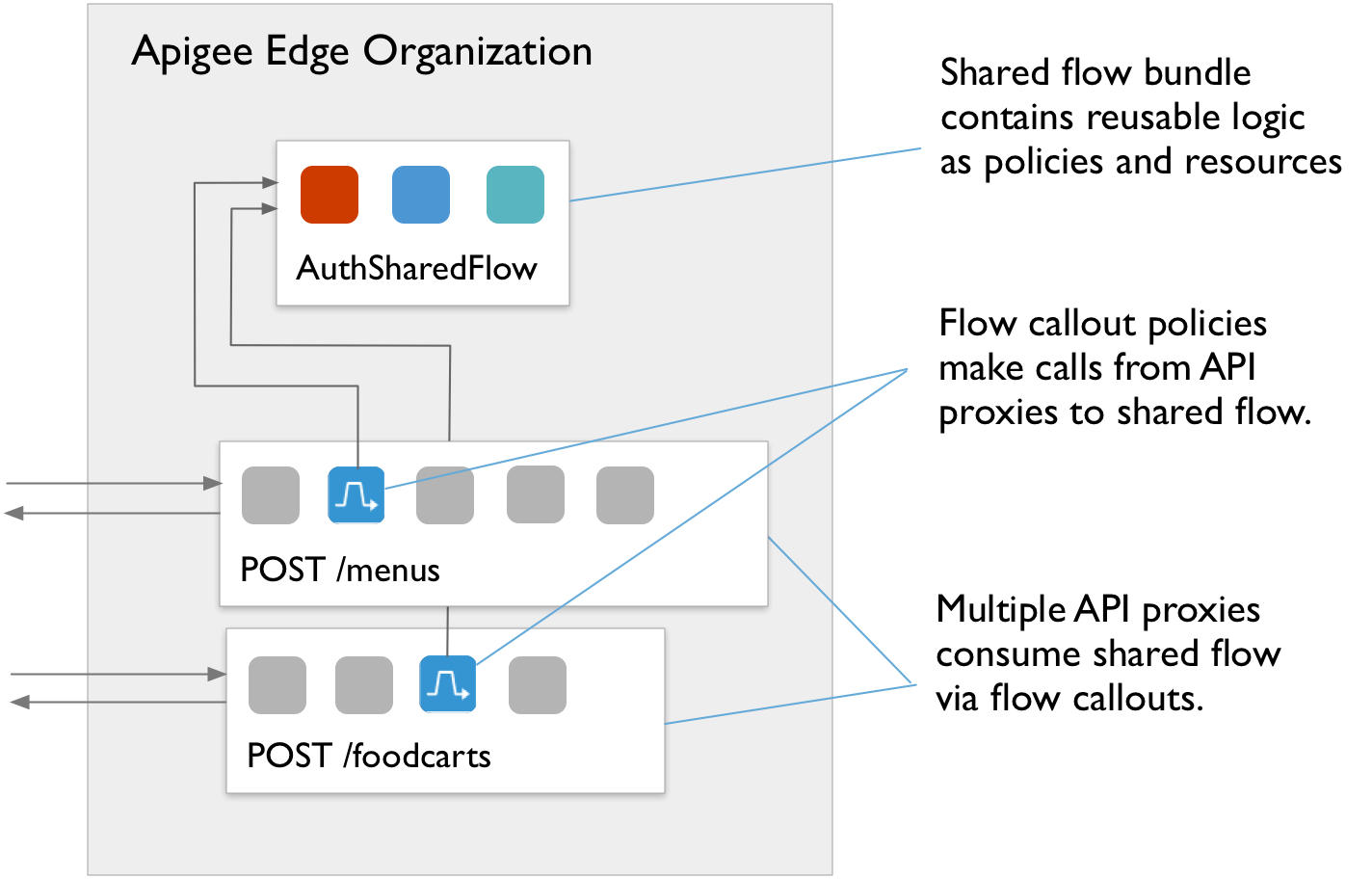

Możesz łączyć zasady i zasoby w udostępniony przepływ, z którego możesz korzystać wielu serwerów proxy API, a nawet z innych współdzielonych przepływów. Choć usługa jest jak serwer proxy, nie ma punktu końcowego. Można go używać tylko przez serwer proxy interfejsu API lub udostępniony przepływ, który działa w tym samym jako współdzielony przepływ.

Dzięki zebraniu w jednym miejscu funkcji, które przydają się w wielu miejscach, wspólny proces zapewnia spójność, skraca czas programowania i ułatwia zarządzanie kodem.

Ten film pokazuje, jak utworzyć i śledzić wspólny przepływ w interfejsie Edge.

Ten 5-minutowy film pokazuje, jak utworzyć i śledzić wspólny przepływ w klasycznej wersji aplikacji. Edge UI (tylko Edge w przypadku Private Cloud).

Możesz wywołać udostępniony przepływ, używając zasady FlowCallout. Oprócz tego dołączając udostępniony proces do haczykiem przepływu, możesz uruchomić udostępniony przepływ przed żądaniem serwera proxy lub docelowym; po odpowiedzi serwera proxy lub celu.

Informacje o zasadach Flowobjaśnienia znajdziesz w zasadach FlowCallout. Więcej informacji: punkty zaczepienia przepływu, patrz Dołączenie współdzielonego przepływu za pomocą haczyka.

Załóżmy na przykład, że masz obszary funkcji, które są używane w wielu miejscach. lub muszą być ustandaryzowane w ramach różnych interfejsów API w organizacji. Można zastosować wspólny proces dla każdego kategoria, w tym:

- zabezpieczeń dzięki kodowi autoryzacji OAuth i weryfikacji klucza interfejsu API oraz kod ochrony przed zagrożeniami.

- logging (logowanie) do generowania standardowych komunikatów o błędach.

- mediation (zapośredniczenie) do przekształcania komunikatów w formatach XML i JSON.

Na poniższej ilustracji 2 serwery proxy interfejsu API wywołują (z zasadą FlowCallout) metodę wywołania współdzielonego przepływu danych do uwierzytelniania przychodzących żądań użytkowników. Zasób AuthSharedFlow został wdrożony niezależnie od organizacji przed serwerami proxy, tak aby była ona dostępna do obsługi żądań serwerów proxy. Wspólny przepływ może zostać opracowany i zarządzany przez zespół odpowiedzialny za całą firmę a potem wykorzystywane w serwerach proxy przez zespoły zajmujące się tworzeniem bardziej wyspecjalizowanych aplikacji.

Tworzenie przepływu współdzielonego

Gdy tworzysz udostępniony przepływ, zawsze musisz go przetestować za pomocą wywołań wysyłanych do serwera proxy interfejsu API. W Innymi słowy, nie możesz wysyłać żądań bezpośrednio do współdzielonego przepływu, tak jak w przypadku serwera proxy interfejsu API. Wysyłasz żądania do serwera proxy interfejsu API, który z kolei wywołuje udostępniany proces.

Oto ogólne kroki potrzebne do opracowania wspólnego procesu:

- Dowiedz się, jaki powinien być wspólny zestaw funkcji.

Możesz na przykład połączyć funkcje zarządzania ruchem, w tym nagłe skoki ruchu. Dzięki temu możesz zarządzać ich konfiguracją poza przepływem pracy i wdrożyć logikę biznesową.

-

Utwórz wspólny proces, wdrażając zasady i materiały pomocnicze tak samo jak Ty

jak przy tworzeniu serwera proxy API.

Wspólny przepływ to sekwencja kroków warunkowych. Dlatego tworzenie takiego kodu jest równoznaczne z opracowaniem Proxy API. Możesz dołączyć zasady i zasoby, które możesz umieścić w serwerze proxy.

Na przykład do zarządzania ruchem możesz zaimplementować kampanię Spike Zasada aresztowania zezwalająca na tylko 30 żądań na sekundę, jak w tym przykładzie:

<SpikeArrest async="false" continueOnError="false" enabled="true" name="Spike-Arrest"> <DisplayName>Spike Arrest</DisplayName> <Properties/> <Identifier ref="request.header.some-header-name"/> <MessageWeight ref="request.header.weight"/> <Rate>30ps</Rate> </SpikeArrest>Następnie, do wspólnego przepływu zarządzania ruchem, możesz dołączyć zasady dotyczące zatrzymywania szczytu jako o krok. Ta zasada jest wykonywana dla każdego serwera proxy interfejsu API, który wywołuje udostępniony przepływ.

<SharedFlow name="default"> <Step> <Name>Spike-Arrest</Name> </Step> </SharedFlow>Informacje o tym, jak rozpocząć udostępniony przepływ w konsoli zarządzania, znajdziesz w materiałach na temat Tworzenie współdzielonego przepływu w interfejsie Edge.

Tak jak w przypadku serwerów proxy API, możesz zaimportować plik ZIP zawierający udostępnione źródło przepływu artefaktów (zobacz Importowanie nowego API Proxy, aby dowiedzieć się więcej o importowaniu serwerów proxy). Poniżej przedstawiono sposób importowania współużytkowany proces z interfejsem API do zarządzania:

curl -X POST -F "file=@/path/to/zip/file.zip" \ 'https://api.enterprise.apigee.com/v1/o/{org_name}/sharedflows?action=import&name=shared-flow-name' \ -u email:password -

Przed wdrożeniem serwerów proxy lub współdzielonych przepływów wdróż udostępniony przepływ w środowisku.

który pochłania. Wdrażasz udostępniony przepływ w taki sam sposób, w jaki wdrażasz serwer proxy interfejsu API. (Do

więcej, przeczytaj artykuł Wdrażanie

).

Współdzielony przepływ musi być w tej samej organizacji i wdrożony w tym samym środowisku co interfejs API. serwerów proxy i innych współdzielonych przepływów, które z niej korzystają. Wdrażanie współdzielonego przepływu przed serwerami proxy umożliwia rozwiązanie zależności serwera proxy od współdzielonego przepływu podczas wdrażania.

Możesz wdrożyć udostępniony przepływ za pomocą wywołania interfejsu zarządzania API, na przykład:

curl -X POST --header "Content-Type: application/octet-stream" \ https://api.enterprise.apigee.com/v1/o/{org_name}/e/{env_name}/sharedflows/{shared_flow_name}/revisions/{revision_number}/deployments \ -u email:passwordMożesz też zastąpić obecnie wdrożony udostępniony przepływ bez przestojów. (Tak Serwery proxy interfejsów API. Zobacz Wdrażanie serwerów proxy interfejsu API przy użyciu: API do zarządzania). Oto formularz żądania za pomocą interfejsu API zarządzania:

curl -X POST --header "Content-Type:application/x-www-form-urlencoded" \ https://api.enterprise.apigee.com/v1/o/{org_name}/e/{env_name}/sharedflows/{shared_flow_name}/revisions/{revision_number}/deployments?"override=true" \ -u email:password -

Opracuj serwer proxy używający interfejsu API, tak aby mógł wywoływać udostępniony przepływ jako część własnego

przepływu danych.

Z serwera proxy interfejsu API wywołujesz udostępniony przepływ z zasadą Flowobjaśnienia. (Możesz podłącz też udostępniony przepływ do serwera proxy za pomocą haczyka przepływu, tak jak to opisano w artykule Dołączanie udostępnionego przepływu za pomocą haka przepływu. Szczegółowe informacje o tworzeniu serwera proxy interfejsu API znajdziesz w artykule Tworzenie pierwszego serwera proxy interfejsu API.

Aby wykorzystać udostępniony przepływ, dodaj zasadę FlowCallout do serwera proxy lub przepływu współdzielonego, i jej konsumpcji. Podobnie jak w przypadku objaśnień dotyczących usług, w których należy wspomnieć o innej usłudze, FlowCallout wspomina o wspólnym procesie. Zużywający serwer proxy interfejsu API musi zostać wdrożony po wspólnej procedurze i w tym samym środowisku co udostępniony proces. Jeśli chcesz przetestować wywołanie do niej za pomocą zasady FlowCallout, musisz mieć udostępniony przepływ.

W poniższym kodzie zasada FlowCallout wywołuje udostępniony przepływ o nazwie

traffic-management-shared<FlowCallout async="false" continueOnError="false" enabled="true" name="Traffic-Management-Flow-Callout"> <DisplayName>Traffic Management FlowCallout</DisplayName> <Properties/> <SharedFlowBundle>traffic-management-shared</SharedFlowBundle> </FlowCallout>Więcej informacji znajdziesz w sekcji Wywoływanie udostępnionego przepływu z serwera proxy interfejsu API lub wspólne przepływy

- Wdróż serwer proxy interfejsu API, który zużywa, aby rozpocząć korzystanie ze współdzielonego przepływu. (Więcej informacji na temat wdrażania zapoznaj się z artykułem Interpretowanie wdrożenie).

-

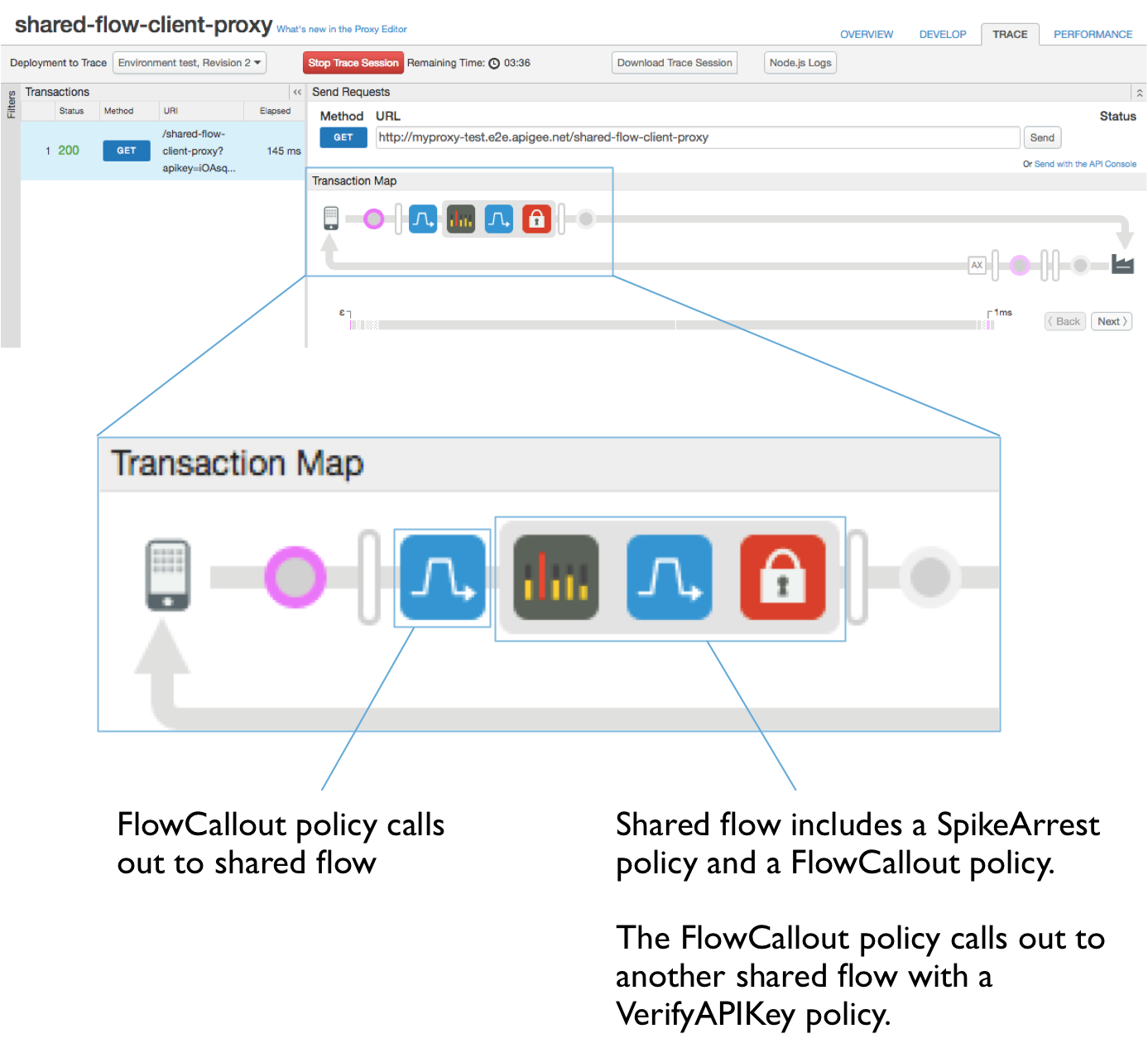

Programuj iteracyjnie przez śledzenie, tak jak w przypadku serwera proxy interfejsu API.

Podobnie jak w przypadku serwera proxy interfejsu API tworzysz udostępniony przepływ przez iteracyjne wywoływanie i śledzenie do używasz logiki w sposób, który najbardziej Ci odpowiada. W tym przypadku udostępniony przepływ nie działa Własny punkt końcowy, wywołujesz punkt końcowy serwera proxy i śledzisz serwer proxy.

Aby to zrobić:

- Upewnij się, że zarówno udostępniony proces, jak i serwer proxy interfejsu API wywołują go za pomocą rozszerzenia FlowCallout są w tej samej organizacji i wdrożone w tym samym środowisku.

- Na karcie Trace (Śledzenie) serwera proxy interfejsu API zacznij śledzić serwer proxy interfejsu API.

- Wyślij żądanie do punktu końcowego serwera proxy na serwerze proxy interfejsu API. Przepływ z punktu końcowego musi uwzględnij zasadę FlowCallout, która odwołuje się do wspólnego przepływu.

- Na karcie Trace (Śledzenie) sprawdź przepływ z serwera proxy interfejsu API do udostępnianego przepływu.

Zwróć uwagę, że w śledzeniu, udostępniony przepływ jest reprezentowany jako zbiór kroków lub zasad. umieszczone w szarym polu. Ikony reprezentujące zasady FlowCallout poprzedzają udostępnione przepływy. Aby dowiedzieć się więcej na temat śledzenia, przeczytaj Korzystanie z Narzędzie śledzenia).

Tworzenie współdzielonego przepływu w interfejsie Edge

Jeśli korzystasz z interfejsu Apigee Edge do utworzenia udostępnionego przepływu, możesz to zrobić za pomocą: lub przez zaimportowanie istniejących źródeł przepływu jako pliku ZIP pakietu przepływów.

- Otwórz stronę Przepływy współdzielone zgodnie z opisem poniżej. Na stronie Przepływy współdzielone możesz wyświetlić listę przepływów współdzielonych w organizacji,

edytować lub usuwać przepływy na liście.

Edge

Aby uzyskać dostęp do strony przepływów współdzielonych za pomocą interfejsu Edge:

- Zaloguj się na stronie apigee.com/edge.

- Wybierz organizację zawierającą udostępniony przepływ. Zobacz Przełączanie się między organizacjami.

Wspólny przepływ będzie dostępny dla wszystkich serwerów proxy API i współdzielonych przepływów wdrożonych w i środowisko tej organizacji. Nie będą dostępne spoza tej organizacji.

- Kliknij Programowanie > Przepływy współdzielone na pasku nawigacyjnym z lewej strony.

Classic Edge (Private Cloud)

Aby uzyskać dostęp do strony przepływów współdzielonych w klasycznej wersji interfejsu Edge:

- Zaloguj się w aplikacji

http://ms-ip:9000, gdzie ms-ip to adres Adres IP lub nazwa DNS węzła serwera zarządzania. - Wybierz organizację zawierającą udostępniony przepływ. Zobacz Przełączanie się między organizacjami.

Wspólny przepływ będzie dostępny dla wszystkich serwerów proxy API i współdzielonych przepływów wdrożonych w i środowisko tej organizacji. Nie będą dostępne spoza tej organizacji.

- Wybierz Interfejsy API > Przepływy współdzielone na górnym pasku nawigacyjnym.

- Kliknij przycisk + Udostępniany przepływ, aby rozpocząć dodawanie nowego przepływu współdzielonego.

- Na stronie Build a Shared Flow (Tworzenie przepływu współdzielonego) wybierz, jak chcesz utworzyć nowy przepływ:

- Utwórz nowy proces od zera. Będziesz mieć możliwość konfigurowania zasad i zasobów jako

w kolejnych krokach.

- Wybierz Empty Shared Flow.

- Wpisz wartość nazwy. Będzie to nazwa używana przez serwery proxy interfejsu API i inne współdzielone przepływy aby odwołać się do tego udostępnionego procesu. Nazwa powinna być opisowa dla programistów i zdecydowanie się na nią.

- Wpisz opis, który będzie zawierać więcej informacji o działaniu przepływu.

- Kliknij Dalej.

- Opcjonalnie wybierz środowiska, w których chcesz wdrożyć nowy przepływ.

Jeśli na przykład będziesz testować wspólny przepływ z serwerów proxy API wdrożonych w w środowisku testowym, a następnie wdróż udostępniony proces testowania.

-

Kliknij Build and Deploy (Tworzenie i wdrażanie), aby utworzyć i wdrożyć nowy wspólny przepływ. wybrane środowiska. Jeśli nie wybierzesz żadnego środowiska, udostępniony przepływ będzie ale nie zostały wdrożone.

- Utwórz wspólny przepływ z istniejących źródeł, przesyłając pakiet przepływu.

- Wybierz Shared Flow Bundle, aby określić plik .zip zawierający artefakty

w ramach nowego procesu.

Pakiet przepływu współdzielonego zawiera artefakty źródłowe udostępnianego przepływu. Przykład: jeśli pobierasz udostępniony proces z interfejsu Edge, masz plik .zip z pakietem przepływu.

- Kliknij Dalej.

- Kliknij Wybierz plik, aby znaleźć plik ZIP zawierający udostępniony proces. źródła, które chcesz zaimportować.

- W polu Shared Flow Name (Nazwa przepływu współdzielonego) wpisz nazwę zaimportowanego przepływu. Dzięki temu to nazwa, której używają serwery proxy interfejsu API i inne współdzielone przepływy w odniesieniu do tego wspólnego przepływu. Nazwa powinna być opisowa dla programistów korzystających z przepływu.

- Kliknij Dalej.

- Kliknij Kompilacja, aby utworzyć nowy proces z importowanych źródeł.

- Wybierz Shared Flow Bundle, aby określić plik .zip zawierający artefakty

w ramach nowego procesu.

- Utwórz nowy proces od zera. Będziesz mieć możliwość konfigurowania zasad i zasobów jako

w kolejnych krokach.

Wywoływanie współdzielonego przepływu z serwera proxy interfejsu API lub współdzielonego przepływu

Możesz wywołać udostępniony przepływ z serwera proxy lub innego udostępnionego procesu, używając FlowCallout policy.

- W interfejsie Edge znajdź serwer proxy lub udostępniony przepływ, z którego chcesz aby wywołać inny udostępniony przepływ.

- W nawigatorze obok Zasady kliknij przycisk +.

- Na liście zasad w sekcji Rozszerzenie kliknij FlowCallout.

- Wpisz wyświetlaną nazwę i nazwę (unikalny identyfikator), a następnie wybierz wspólny przepływ, .

- Kliknij Dodaj.

- Dodaj nową zasadę FlowCallout do serwera proxy, na którym ma być nawiązywane wywołanie.